No ano passado, o Instituto Max Planck de Sistemas Inteligentes organizou o Real Robot Challenge, uma competição que desafiava laboratórios acadêmicos a encontrar soluções para o problema de reposicionamento e reorientação de um cubo usando uma mão robótica de baixo custo. As equipes participantes do desafio foram solicitadas a resolver uma série de problemas de manipulação de objetos com vários níveis de dificuldade.

Para resolver um dos problemas apresentados pelo Real Robot Challenge, pesquisadores do Vector Institute da Universidade de Toronto, ETH Zurich e MPI Tubingen desenvolveram um sistema que permite que os robôs adquiram habilidades desafiadoras de manipulação destra, transferindo essas habilidades de simulações para um robô real. Este sistema, apresentado em um artigo pré-publicado no arXiv, alcançou uma taxa de sucesso notável de 83% ao permitir que o sistema TriFinger remoto proposto pelos organizadores do desafio concluísse tarefas desafiadoras que envolviam manipulação hábil.

“Nosso objetivo era usar métodos baseados em aprendizagem para resolver o problema apresentado no Real Robot Challenge do ano passado de uma forma de baixo custo”, disse Animesh Garg, um dos pesquisadores que realizou o estudo, ao TechXplore. “Estamos particularmente inspirados pelo trabalho anterior no sistema Dactyl da OpenAI, que mostrou que é possível usar o Aprendizado por Reforço livre de modelos em combinação com a Randomização de Domínio para resolver tarefas complexas de manipulação.”

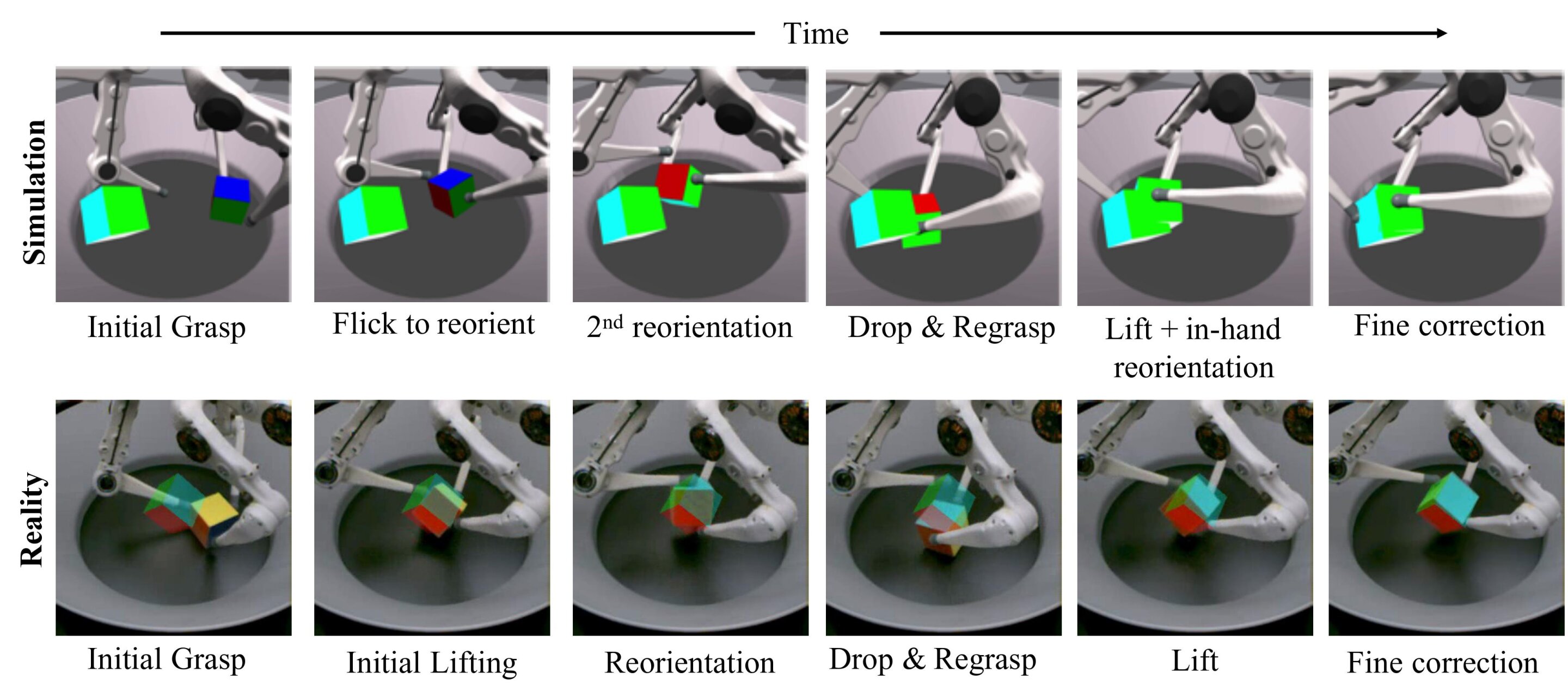

Essencialmente, Garg e seus colegas queriam demonstrar que podiam resolver tarefas de manipulação hábil usando um sistema robótico Trifinger, transferindo os resultados obtidos em simulações para o mundo real usando menos recursos do que aqueles empregados em estudos anteriores. Para isso, eles treinaram um agente de aprendizado por reforço em simulações e criaram uma técnica de aprendizado profundo que pode planejar ações futuras com base nas observações de um robô.

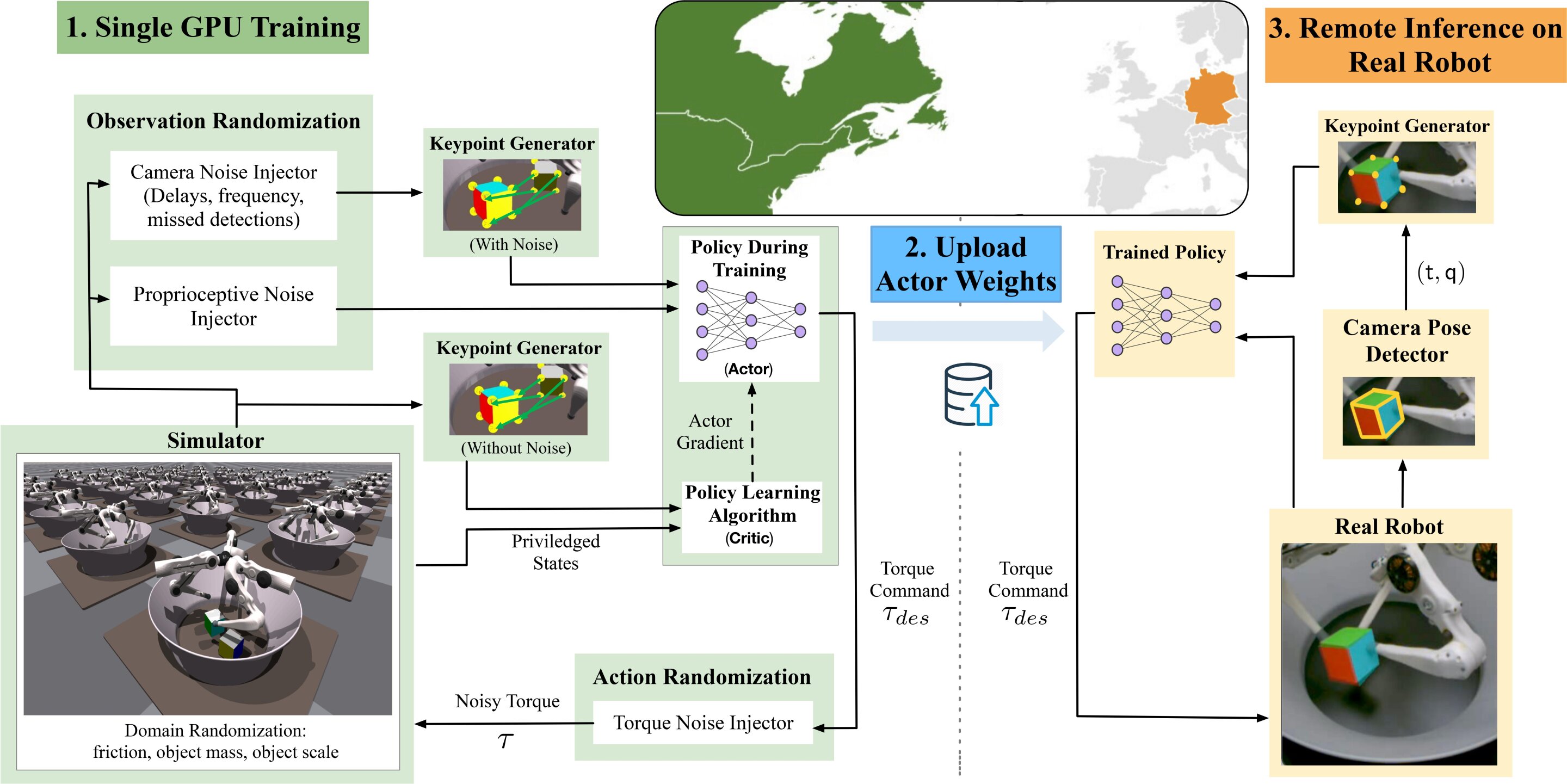

“O processo que seguimos consiste em quatro etapas principais: configurar o ambiente em simulação de física, escolher a parametrização correta para a especificação de um problema, aprender uma política robusta e implantar nossa abordagem em um robô real”, explicou Garg. “Primeiro, criamos um ambiente de simulação correspondente ao cenário do mundo real que estávamos tentando resolver.”

O ambiente simulado foi criado usando o Isaac Gym Simulator, lançado recentemente pela NVIDIA. Este simulador pode realizar simulações altamente realistas, aproveitando o poder das GPUs NVIDIA. Ao usar a plataforma Isaac Gym, Garg e seus colegas foram capazes de reduzir significativamente a quantidade de cálculos necessários para traduzir habilidades de manipulação hábil de simulações para configurações do mundo real, diminuindo os requisitos de seu sistema de um cluster com centenas de CPUs e várias GPUs para um GPU única.

“O aprendizado por reforço requer que usemos representações de variáveis em nosso problema apropriadas para resolver a tarefa”, disse Garg. “O desafio Real Robot exigia que os competidores descansassem os cubos tanto na posição quanto na orientação. Isso tornou a tarefa significativamente mais desafiadora do que os esforços anteriores, pois o controlador de rede neural aprendido precisava ser capaz de negociar esses dois objetivos.”

Para resolver o problema de manipulação de objetos colocado pelo desafio Real Robot, Garg e seus colegas decidiram usar a ‘representação de ponto-chave’, uma forma de representar objetos focalizando os principais ‘pontos de interesse’ em uma imagem. Esses são pontos que permanecem inalterados independentemente do tamanho, rotação, distorções ou outras variações de uma imagem.

Em seu estudo, os pesquisadores usaram pontos-chave para representar a pose de um cubo que se esperava que o robô manipulasse nos dados de imagem enviados à sua rede neural. Eles também os usaram para calcular a chamada função de recompensa, que pode permitir que algoritmos de aprendizado por reforço melhorem seu desempenho ao longo do tempo.

“Finalmente, adicionamos randomizações ao ambiente”, disse Garg. “Isso inclui a randomização das entradas para a rede, as ações que ela executa, bem como vários parâmetros do ambiente, como a fricção do cubo e a adição de forças aleatórias sobre ele. O resultado disso é forçar o controlador da rede neural a exibir um comportamento que é robusto para uma variedade de parâmetros de ambiente. ”

Os pesquisadores treinaram seu modelo de aprendizagem por reforço no ambiente simulado que criaram usando o Isaac Gym, ao longo de um dia. Na simulação, o algoritmo foi apresentado com 16.000 robôs simulados, produzindo ~ 50.000 passos / segundo de dados que foram usados para treinar a rede.

“A política foi então enviada para a fazenda de robôs, onde foi implantada em um robô aleatório de um pool de vários robôs semelhantes”, disse Garg. “Aqui, a política não é treinada novamente com base nos parâmetros exclusivos de cada robô – ela já é capaz de se adaptar a eles. Após a tarefa de manipulação ser concluída, os dados são carregados para serem acessados pelos pesquisadores”.

Garg e seus colegas conseguiram transferir com eficácia os resultados obtidos por seu algoritmo de aprendizado de reforço profundo em simulações para robôs reais, com muito menos poder computacional do que outras equipes exigiam no passado. Além disso, eles demonstraram a integração eficaz de ferramentas de simulação altamente paralelas com métodos modernos de aprendizado de reforço profundo para resolver com eficácia tarefas desafiadoras de manipulação destra.

Os pesquisadores também descobriram que o uso da representação de pontos-chave levou a um treinamento mais rápido e a uma maior taxa de sucesso em tarefas do mundo real. No futuro, a estrutura que eles desenvolveram pode ajudar a acelerar a pesquisa sobre manipulação hábil e transferência sim2real, por exemplo, permitindo aos pesquisadores desenvolver políticas inteiramente em simulação com recursos computacionais moderados e implantá-las em robôs reais de baixo custo.

“Esperamos agora desenvolver nossa estrutura para continuar avançando no estado de manipulação em mãos para uma manipulação de propósito geral além do reposicionamento em mãos”, disse Garg. “Este trabalho estabelece a base para estudarmos os conceitos centrais da linguagem da manipulação, particularmente as tarefas que envolvem a preensão direta e a reorientação de objetos, que vão desde a abertura de garrafas de água a agarrar xícaras de café.”

Publicado em 22/10/2021 07h54

Artigo original:

Estudo original: