Ao longo da última década, muitos roboticistas e cientistas da computação têm tentado desenvolver robôs que possam completar tarefas em espaços habitados por humanos; por exemplo, ajudando os usuários a cozinhar, limpar e arrumar. Para lidar com tarefas domésticas e outras tarefas manuais, os robôs devem ser capazes de resolver tarefas de planejamento complexas que envolvem navegar em ambientes e interagir com objetos seguindo sequências específicas.

Embora algumas técnicas para resolver essas tarefas complexas de planejamento tenham alcançado resultados promissores, a maioria delas não está totalmente equipada para enfrentá-los. Como resultado, os robôs ainda não podem completar essas tarefas tão bem quanto os agentes humanos.

Pesquisadores da UT Austin e do Facebook AI Research desenvolveram recentemente uma nova estrutura que pode moldar o comportamento de agentes corporificados de forma mais eficaz, usando vídeos egocêntricos de humanos completando tarefas cotidianas. Seu artigo, pré-publicado no arXiv e programado para ser apresentado na Conferência Neural Information Processing Systems (NeurIPS) em dezembro, apresenta uma abordagem mais eficiente para o treinamento de robôs para realizar tarefas domésticas e outras tarefas de interação intensa.

“O objetivo exagerado deste projeto era construir agentes robóticos incorporados que podem aprender observando as pessoas interagirem com o ambiente”, disse Tushar Nagarajan, um dos pesquisadores que realizaram o estudo, ao TechXplore. “As abordagens de aprendizagem por reforço (RL) exigem milhões de tentativas de aprender o comportamento inteligente conforme os agentes começam tentando ações aleatoriamente, enquanto as abordagens de aprendizagem por imitação (IL) exigem que especialistas controlem e demonstrem o comportamento ideal do agente, que é caro para coletar e requer hardware extra. ”

Em contraste com os sistemas robóticos, ao entrar em um novo ambiente, os humanos podem realizar tarefas que envolvem objetos diferentes sem esforço. Nagarajan e sua colega Kristen Grauman começaram a investigar se os agentes corporificados poderiam aprender a completar tarefas em ambientes semelhantes simplesmente observando como os humanos se comportam.

Em vez de treinar agentes usando demonstrações de vídeo marcadas por humanos, que muitas vezes são caras de coletar, os pesquisadores queriam aproveitar imagens de vídeo egocêntricas (em primeira pessoa) mostrando pessoas realizando atividades cotidianas, como cozinhar uma refeição ou lavar pratos. Esses vídeos são mais fáceis de coletar e mais acessíveis do que as demonstrações anotadas.

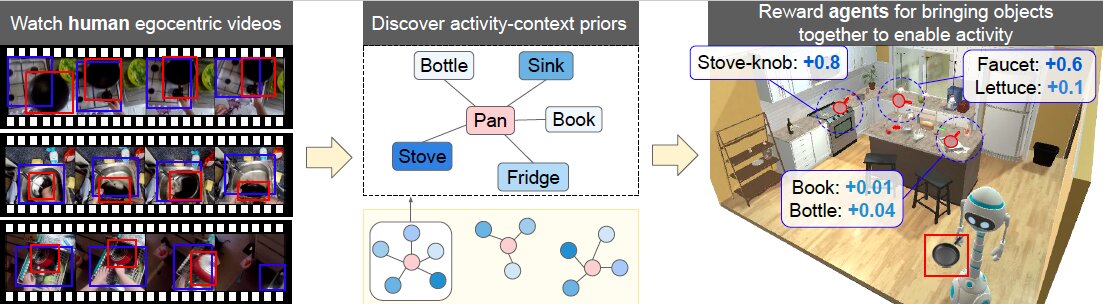

“Nosso trabalho é o primeiro a usar vídeo de forma livre gerado por humanos capturado no mundo real para aprender os antecedentes para interações de objetos”, disse Nagarajan. “Nossa abordagem converte vídeos egocêntricos de humanos interagindo com seus arredores em antecedentes de ‘contexto de atividade’, que capturam quais objetos, quando reunidos, permitem atividades. Por exemplo, assistir humanos lavando a louça sugere que utensílios, saboneteira e uma esponja são bons objetos para se ter antes de abrir a torneira da pia. ”

Para adquirir esses ‘antecedentes’ (por exemplo, informações úteis sobre quais objetos reunir antes de concluir uma tarefa), o modelo criado por Nagarajan e Grauman acumula estatísticas sobre pares de objetos que os humanos tendem a usar durante atividades específicas. Seu modelo detectou diretamente esses objetos em vídeos egocêntricos do grande conjunto de dados usado pelos pesquisadores.

Posteriormente, o modelo codificou os antecedentes que adquiriu como uma recompensa em uma estrutura de aprendizagem por reforço. Essencialmente, isso significa que um agente é recompensado com base nos objetos que selecionou para concluir uma determinada tarefa.

“Por exemplo, abrir a torneira recebe uma grande recompensa quando uma panela é aproximada da pia (e uma recompensa baixa se, digamos, um livro for trazido para perto dela)”, explicou Nagarajan. “Como consequência, um agente deve trazer de forma inteligente o conjunto certo de objetos para os locais certos antes de tentar interações com objetos, a fim de maximizar sua recompensa. Isso os ajuda a alcançar estados que levam a atividades, o que acelera o aprendizado.”

Estudos anteriores tentaram acelerar o aprendizado de políticas de robôs usando funções de recompensa semelhantes. No entanto, normalmente essas são recompensas de exploração que incentivam os agentes a explorar novos locais ou realizar novas interações, sem considerar especificamente as tarefas humanas que estão aprendendo a realizar.

“Nossa formulação melhora essas abordagens anteriores, alinhando as recompensas com as atividades humanas, ajudando os agentes a explorar interações de objetos mais relevantes”, disse Nagarajan. “Nosso trabalho também é único no sentido de que aprende antecedentes sobre interações de objeto de vídeo de forma livre, ao invés de vídeo vinculado a objetivos específicos (como na clonagem de comportamento). O resultado é uma recompensa auxiliar de propósito geral para encorajar RL eficiente.”

Em contraste com os antecedentes considerados por abordagens desenvolvidas anteriormente, os antecedentes considerados pelo modelo dos pesquisadores também capturam como os objetos estão relacionados no contexto das ações que o robô está aprendendo a realizar, ao invés de meramente sua coocorrência física (por exemplo, colheres podem ser encontrado perto de facas) ou semelhança semântica (por exemplo, batatas e tomates são objetos semelhantes).

Os pesquisadores avaliaram seu modelo usando um conjunto de dados de vídeos egocêntricos mostrando humanos enquanto eles completam as tarefas diárias e tarefas na cozinha. Seus resultados foram promissores, sugerindo que seu modelo poderia ser usado para treinar robôs domésticos de forma mais eficaz do que outras técnicas desenvolvidas anteriormente.

“Nosso trabalho é o primeiro a demonstrar que o vídeo passivo de humanos realizando atividades diárias pode ser usado para aprender políticas de interação incorporadas”, disse Nagarajan. “Esta é uma conquista significativa, pois o vídeo egocêntrico está prontamente disponível em grandes quantidades a partir de conjuntos de dados recentes. Nosso trabalho é um primeiro passo para habilitar aplicativos que podem aprender sobre como os humanos realizam atividades (sem a necessidade de demonstrações dispendiosas) e, então, oferecer assistência em a configuração da robótica doméstica. ”

No futuro, a nova estrutura desenvolvida por esta equipe de pesquisadores poderá ser usada para treinar uma variedade de robôs físicos para realizar uma variedade de tarefas simples do dia a dia. Além disso, poderia ser usado para treinar assistentes de realidade aumentada (RA), que poderiam, por exemplo, observar como um humano cozinha um determinado prato e, então, ensinar novos usuários a prepará-lo.

“Nossa pesquisa é um passo importante para aprender observando humanos, pois captura antecedentes simples, mas poderosos, sobre objetos envolvidos em atividades”, acrescentou Nagarajan. “No entanto, há outras coisas significativas para aprender, como: Quais partes do ambiente suportam atividades (possibilidades de cena)? Como os objetos devem ser manipulados ou apreendidos para usá-los? Existem sequências importantes de ações (rotinas) que podem ser aprendidas e alavancado por agentes incorporados? Finalmente, uma importante direção de pesquisa futura a seguir é como pegar políticas aprendidas em ambientes simulados e implantá-las em plataformas de robôs móveis ou óculos AR, a fim de construir agentes que possam cooperar com humanos no mundo real. ”

Publicado em 05/11/2021 11h28

Artigo original:

Estudo original: