Nas últimas décadas, os engenheiros criaram dispositivos com funções e recursos cada vez mais avançados. Uma capacidade do dispositivo que foi substancialmente melhorada nos últimos anos é conhecida como “computação espacial”.

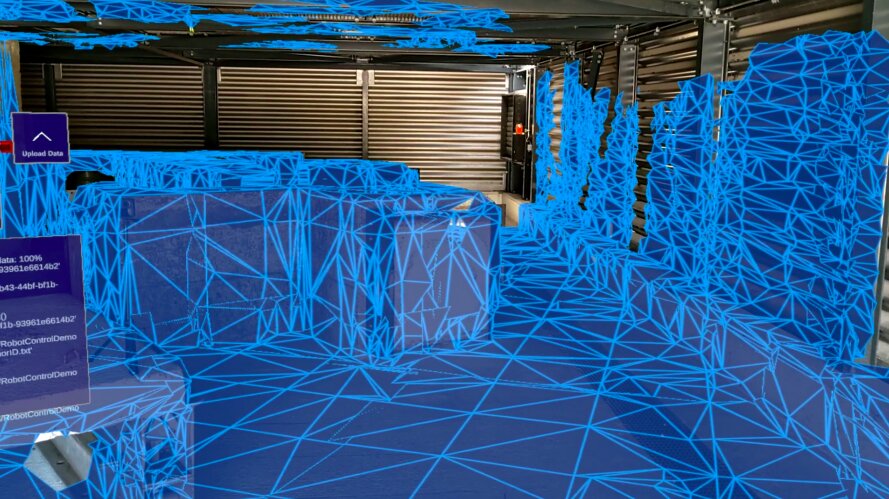

O termo computação espacial refere-se essencialmente à capacidade de computadores, robôs e outros dispositivos eletrônicos de estarem “conscientes” de seu ambiente circundante e de criar representações digitais dele. Tecnologias de ponta, como sensores e realidade mista (MR), podem aprimorar significativamente a computação espacial, permitindo a criação de sistemas sofisticados de detecção e mapeamento.

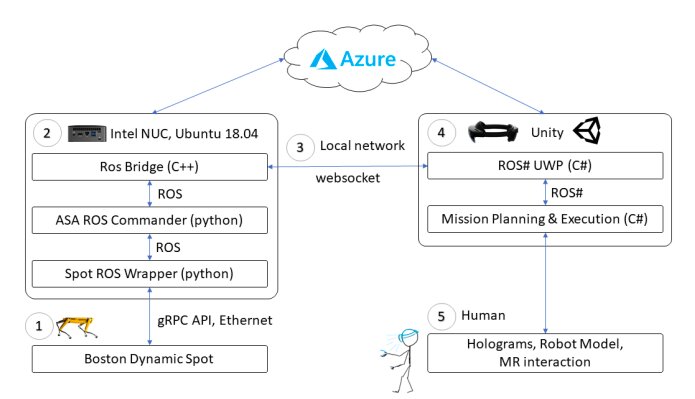

Pesquisadores do Microsoft Mixed Reality and AI Lab e ETH Zurich desenvolveram recentemente uma nova estrutura que combina RM e robótica para aprimorar aplicativos de computação espacial. Eles implementaram e testaram esse framework, introduzido em um artigo pré-publicado no arXiv, em uma série de sistemas para interação humano-robô.

“A combinação de computação espacial e detecção egocêntrica em dispositivos de realidade mista permite que eles capturem e entendam as ações humanas e as traduzam em ações com significado espacial, o que oferece novas e emocionantes possibilidades de colaboração entre humanos e robôs”, escreveram os pesquisadores em seu artigo. “Este artigo apresenta vários sistemas humano-robô que utilizam esses recursos para permitir novos casos de uso de robôs: planejamento de missão para inspeção, controle baseado em gestos e teleoperação imersiva”.

A estrutura baseada em RM e robótica desenvolvida por esta equipe de pesquisadores foi implementada em três sistemas diferentes com funções diferentes. Notavelmente, todos esses sistemas exigem o uso de um headset HoloLens MR.

O primeiro sistema é projetado para planejar missões de robôs que envolvem a inspeção de um determinado ambiente. Essencialmente, um usuário humano se move no ambiente que deseja inspecionar usando um headset HoloLens, colocando hologramas em forma de waypoints que definem a trajetória de um robô. Além disso, o usuário pode destacar áreas específicas onde deseja que um robô colete imagens ou dados. Essas informações são processadas e traduzidas, para que possam ser usadas posteriormente para orientar os movimentos e ações de um robô durante a inspeção do ambiente.

O segundo sistema proposto pelos pesquisadores é uma interface que permite que usuários humanos interajam com o robô de forma mais eficaz, por exemplo, controlando os movimentos do robô por meio de gestos manuais. Além disso, este sistema permite a colocalização de diferentes dispositivos, incluindo headsets de RM, smartphones e robôs.

“A colocalização de dispositivos requer que cada um deles seja capaz de se localizar em um sistema de coordenadas de referência comum”, escreveram os pesquisadores. “Através de suas poses individuais em relação a esse quadro de coordenadas comum, a transformação relativa entre dispositivos localizados pode ser calculada e, posteriormente, usada para permitir novos comportamentos e colaboração entre dispositivos”.

Para colocar os dispositivos, a equipe introduziu uma estrutura que garante que todos os dispositivos em seus sistemas compartilhem suas posições em relação uns aos outros e um mapa de referência comum. Além disso, os usuários podem usar o headset HoloLens para fornecer instruções de navegação aos robôs, simplesmente realizando uma série de gestos intuitivos com as mãos.

Finalmente, o terceiro sistema permite a teleoperação imersiva, o que significa que um usuário pode controlar remotamente um robô enquanto visualiza o ambiente ao redor. Esse sistema pode ser particularmente valioso nos casos em que um robô será necessário para navegar em um ambiente inacessível aos humanos.

“Exploramos a projeção das ações de um usuário para um robô remoto e a sensação de espaço do robô de volta ao usuário”, explicaram os pesquisadores. “Consideramos vários níveis de imersão, baseados em tocar e manipular um modelo do robô para controlá-lo, e a imersão de nível superior de se tornar o robô e mapear o movimento do usuário diretamente para o robô”.

Nos testes iniciais, os três sistemas propostos por Jeffrey Delmerico e seus colegas da Microsoft alcançaram resultados altamente promissores, destacando o potencial do uso de MR para aprimorar tanto a computação espacial quanto a interação humano-robô. No futuro, esses sistemas poderão ser introduzidos em muitas configurações diferentes, permitindo que os humanos colaborem de perto com os robôs para resolver com eficiência uma ampla gama de problemas complexos do mundo real.

Publicado em 06/03/2022 05h20

Artigo original:

Estudo original: