Obter uma leitura rápida e precisa de um raio-X ou de outras imagens médicas pode ser vital para a saúde do paciente e pode até salvar uma vida. A obtenção dessa avaliação depende da disponibilidade de um radiologista habilitado e, consequentemente, nem sempre é possível uma resposta rápida.

Por essa razão, diz Ruizhi “Ray” Liao, pós-doutorado e recém-graduado no Laboratório de Ciência da Computação e Inteligência Artificial do MIT (CSAIL), “queremos treinar máquinas capazes de reproduzir o que os radiologistas fazem todos os dias”. Liao é o primeiro autor de um novo artigo, escrito com outros pesquisadores do MIT e dos hospitais da área de Boston, que está sendo apresentado neste outono no MICCAI 2021, uma conferência internacional sobre computação de imagens médicas.

Embora a ideia de utilizar computadores para interpretar imagens não seja nova, o grupo liderado pelo MIT está recorrendo a um recurso subutilizado – o vasto corpo de relatórios de radiologia que acompanham as imagens médicas, escritos por radiologistas na prática clínica de rotina – para melhorar as habilidades interpretativas de algoritmos de aprendizado de máquina. A equipe também está utilizando um conceito da teoria da informação denominado informação mútua – uma medida estatística da interdependência de duas variáveis diferentes – para aumentar a eficácia de sua abordagem.

É assim que funciona: primeiro, uma rede neural é treinada para determinar a extensão de uma doença, como edema pulmonar, sendo apresentada a inúmeras imagens de raios-X dos pulmões dos pacientes, juntamente com a avaliação do médico sobre a gravidade de cada caso . Essas informações são encapsuladas em uma coleção de números. Uma rede neural separada faz o mesmo para texto, representando suas informações em uma coleção diferente de números. Uma terceira rede neural então integra as informações entre as imagens e o texto de uma forma coordenada que maximiza as informações mútuas entre os dois conjuntos de dados. “Quando a informação mútua entre as imagens e o texto é alta, isso significa que as imagens são altamente preditivas do texto e o texto é altamente preditivo das imagens”, explica a professora Polina Golland do MIT, investigadora principal do CSAIL.

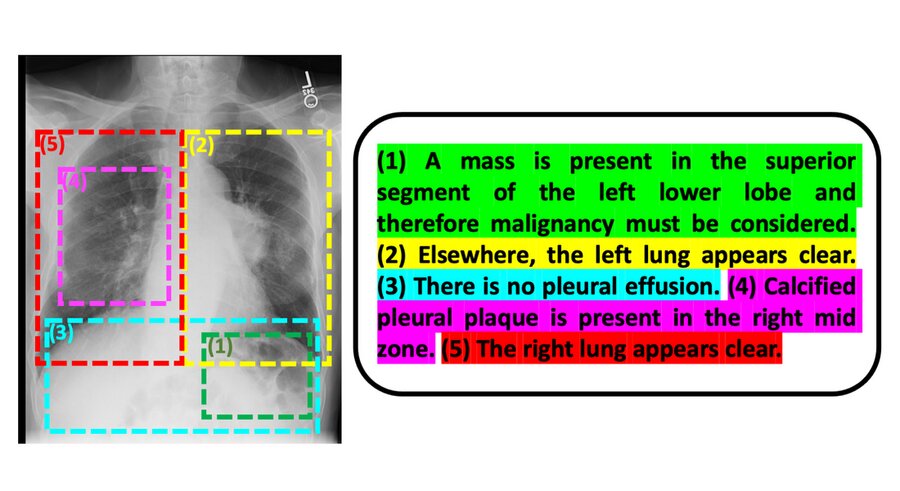

Liao, Golland e seus colegas introduziram outra inovação que confere várias vantagens: em vez de trabalhar com imagens inteiras e relatórios de radiologia, eles dividem os relatórios em sentenças individuais e as partes dessas imagens às quais as sentenças pertencem. Fazendo as coisas dessa maneira, diz Golland, “estima a gravidade da doença com mais precisão do que se você ver a imagem inteira e o relatório inteiro. E como o modelo está examinando pedaços menores de dados, ele pode aprender mais prontamente e tem mais amostras para treinar sobre.”

Embora Liao considere os aspectos da ciência da computação deste projeto fascinantes, sua principal motivação é “desenvolver tecnologia que seja clinicamente significativa e aplicável ao mundo real”.

O modelo poderia ter aplicabilidade muito ampla, segundo Golland. “Ele poderia ser usado para qualquer tipo de imagem e texto associado – dentro ou fora da área médica. Essa abordagem geral, além disso, poderia ser aplicada além de imagens e texto, o que é empolgante de se pensar.”

Publicado em 28/09/2021 11h21

Artigo original:

Estudo original: