Periódicos e pesquisadores estão sendo criticados por estudos polêmicos usando essa tecnologia. E uma pesquisa da Nature revela que muitos pesquisadores neste campo acham que há um problema.

Em setembro de 2019, quatro pesquisadores escreveram ao editor Wiley para “pedir respeitosamente” que se retirasse imediatamente um artigo científico. O estudo, publicado em 2018, treinou algoritmos para distinguir os rostos do povo uigur, uma minoria étnica predominantemente muçulmana na China, daqueles de etnia coreana e tibetana.

A China já havia sido condenada internacionalmente por sua vigilância pesada e detenções em massa de uigures em campos na província de Xinjiang, no noroeste – que o governo diz serem centros de reeducação destinados a reprimir um movimento terrorista. De acordo com relatos da mídia, as autoridades em Xinjiang usaram câmeras de vigilância equipadas com software sintonizado com os rostos uigures.

Como resultado, muitos pesquisadores acharam preocupante que acadêmicos tivessem tentado construir tais algoritmos – e que um jornal americano tivesse publicado um artigo de pesquisa sobre o assunto. E o estudo de 2018 não foi o único: periódicos de editoras como Springer Nature, Elsevier e o Instituto de Engenheiros Elétricos e Eletrônicos (IEEE) também publicaram artigos revisados por pares que descrevem o uso de reconhecimento facial para identificar uigures e membros de outros chineses grupos minoritários. (A equipe de notícias da Nature é editorialmente independente de sua editora, Springer Nature.)

A denúncia, que lançou uma investigação em andamento, foi uma incursão em um impulso crescente de alguns cientistas e ativistas de direitos humanos para fazer a comunidade científica adotar uma posição mais firme contra pesquisas antiéticas de reconhecimento facial. É importante denunciar os usos controversos da tecnologia, mas isso não é suficiente, dizem os especialistas em ética. Os cientistas também devem reconhecer os fundamentos moralmente duvidosos de grande parte do trabalho acadêmico na área – incluindo estudos que coletaram enormes conjuntos de dados de imagens de rostos de pessoas sem consentimento, muitos dos quais ajudaram a aprimorar algoritmos de vigilância comercial ou militar. (Um recurso vinculado explora questões sobre o viés algorítmico em sistemas de reconhecimento facial.)

Um número crescente de cientistas está incentivando os pesquisadores a evitar trabalhar com empresas ou universidades ligadas a projetos antiéticos, a reavaliar como eles coletam e distribuem conjuntos de dados de reconhecimento facial e a repensar a ética de seus próprios estudos. Algumas instituições já estão dando passos nessa direção. No ano passado, vários periódicos e uma conferência acadêmica anunciaram verificações éticas extras nos estudos.

“Muitas pessoas estão se perguntando por que a comunidade da visão computacional dedica tanta energia ao trabalho de reconhecimento facial quando é tão difícil fazê-lo com ética”, diz Deborah Raji, pesquisadora em Ottawa que trabalha na fundação sem fins lucrativos da Internet Mozilla. “Estou vendo uma coalizão crescente que é apenas contra toda essa empresa.”

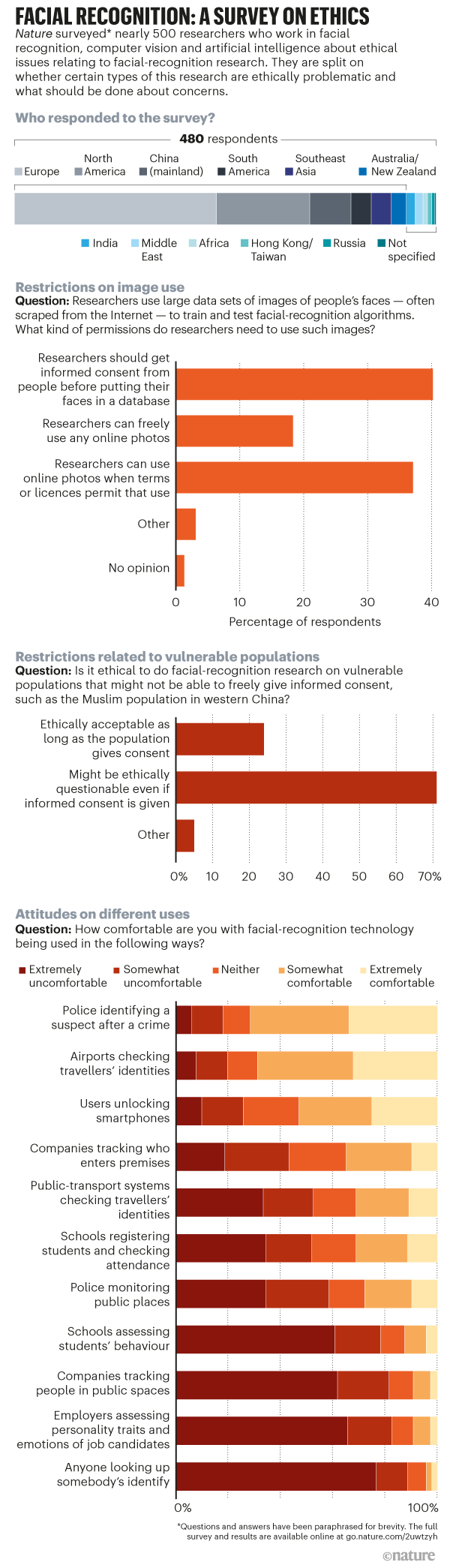

Este ano, a Nature pediu a 480 pesquisadores ao redor do mundo que trabalham com reconhecimento facial, visão computacional e inteligência artificial (IA) sobre suas opiniões sobre questões éticas espinhosas sobre a pesquisa de reconhecimento facial. Os resultados desta pesquisa inédita sugerem que alguns cientistas estão preocupados com a ética do trabalho neste campo – mas outros ainda não consideram os estudos acadêmicos problemáticos.

Dados sem consentimento

Para que os algoritmos de reconhecimento facial funcionem bem, eles devem ser treinados e testados em grandes conjuntos de dados de imagens, idealmente capturados muitas vezes em diferentes condições de iluminação e em diferentes ângulos. Nas décadas de 1990 e 2000, os cientistas geralmente conseguiam voluntários para posar para essas fotos – mas a maioria agora coleta imagens faciais sem pedir permissão.

Por exemplo, em 2015, cientistas da Universidade de Stanford, na Califórnia, publicaram um conjunto de 12.000 imagens de uma webcam em um café de São Francisco que foram transmitidas ao vivo online. No ano seguinte, pesquisadores da Duke University em Durham, Carolina do Norte, divulgaram mais de 2 milhões de quadros de vídeo (85 minutos) de imagens de alunos caminhando no campus da universidade.

As maiores coleções foram reunidas online. Em 2016, pesquisadores da Universidade de Washington em Seattle postaram um banco de dados, chamado MegaFace, de 3,3 milhões de fotos do site de compartilhamento de imagens Flickr. E os cientistas da Microsoft Research em Redmond, Washington, divulgaram o maior conjunto de dados do mundo, o MSCeleb, que consiste em 10 milhões de imagens de quase 100.000 pessoas, incluindo jornalistas, músicos e acadêmicos, retiradas da Internet.

Em 2019, o artista radicado em Berlim Adam Harvey criou um site chamado MegaPixels que sinalizou esses e outros conjuntos de dados. Ele e outro tecnólogo e programador baseado em Berlim, Jules LaPlace, mostraram que muitos foram compartilhados abertamente e usados para avaliar e melhorar os produtos comerciais de vigilância. Alguns foram citados, por exemplo, por empresas que trabalharam em projetos militares na China. “Eu queria descobrir a incômoda verdade de que muitas das fotos que as pessoas postam online têm uma vida após a morte como dados de treinamento”, diz Harvey. No total, ele diz ter mapeado 29 conjuntos de dados, usados em cerca de 900 projetos de pesquisa. Os pesquisadores costumam usar imagens públicas do Flickr carregadas sob licenças de direitos autorais que permitem a reutilização liberal.

Depois que o Financial Times publicou um artigo sobre o trabalho de Harvey em 2019, a Microsoft e várias universidades retiraram seus conjuntos de dados. A maioria disse na ocasião – e reiterou à Nature este mês – que seus projetos foram concluídos ou que os pesquisadores solicitaram a remoção do conjunto de dados. O cientista da computação Carlo Tomasi, da Duke University, foi o único pesquisador a se desculpar por um erro. Em um comunicado, dois meses após o conjunto de dados ter sido retirado, ele disse que obteve a aprovação do Comitê de Revisão Institucional (IRB) para suas gravações – que sua equipe fez para analisar o movimento de objetos em vídeo, não para reconhecimento facial. Mas a orientação do IRB disse que ele não deveria ter gravado ao ar livre e não deveria ter disponibilizado os dados sem proteção por senha. Tomasi disse à Nature que ele fez esforços para alertar os alunos, colocando cartazes para descrever o projeto.

A remoção dos conjuntos de dados parece ter diminuído um pouco o uso, diz Harvey. Mas grandes coleções de imagens online, como o MSCeleb, ainda são distribuídas entre pesquisadores, que continuam a citá-las e, em alguns casos, os reenviaram ou conjuntos de dados derivados deles. Os cientistas às vezes estipulam que os conjuntos de dados devem ser usados apenas para pesquisas não comerciais – mas, uma vez que tenham sido amplamente compartilhados, é impossível impedir as empresas de obtê-los e usá-los.

Em outubro, cientistas da computação da Universidade de Princeton, em Nova Jersey, relataram a identificação de 135 artigos publicados depois que o conjunto de dados do Duke foi retirado e que o usaram ou os dados derivados dele (consulte go.nature.com/3nlkjre). Os autores pediram aos pesquisadores que estabeleçam mais restrições ao uso de conjuntos de dados e pediram aos periódicos que parassem de aceitar artigos que utilizassem conjuntos de dados retirados.

Legalmente, não está claro se os cientistas na Europa podem coletar fotos de rostos de indivíduos para pesquisas biométricas sem seu consentimento. O alardeado Regulamento Geral de Proteção de Dados (GDPR) da União Europeia não fornece uma base jurídica óbvia para os pesquisadores fazerem isso, relatou Catherine Jasserand, pesquisadora de biometria e lei de privacidade da Universidade Católica de Leuven, na Bélgica, em 2018. Mas houve não houve orientação oficial sobre como interpretar o GDPR neste ponto, e ele não foi testado nos tribunais. Nos Estados Unidos, alguns estados dizem que é ilegal para empresas comerciais usar os dados biométricos de uma pessoa sem seu consentimento; Illinois é o único a permitir que indivíduos processem por isso. Como resultado, várias empresas foram atingidas por ações judiciais coletivas.

A empresa de mídia social americana Facebook, por exemplo, concordou este ano em pagar US $ 650 milhões para resolver uma ação coletiva de Illinois sobre uma coleção de fotos que não estava disponível publicamente, que foi usada para reconhecimento facial (agora permite aos usuários desativar a marcação de reconhecimento facial). A polêmica empresa de tecnologia Clearview AI, com sede em Nova York – que afirma ter retirado três bilhões de fotos online para um sistema de reconhecimento facial – também foi processada por violar esta lei em casos pendentes. E as empresas de tecnologia dos EUA IBM, Google, Microsoft, Amazon e FaceFirst também foram processadas em Illinois por usar um conjunto de dados de quase um milhão de fotos online que a IBM divulgou em janeiro de 2019; A IBM o removeu na época do processo, que seguiu um relatório da NBC News detalhando a inquietação dos fotógrafos por suas fotos estarem no conjunto de dados.

A Microsoft disse à Nature que entrou com o pedido para encerrar o caso, e Clearview diz que “pesquisa apenas informações publicamente disponíveis, como o Google ou qualquer outro mecanismo de busca”. Outras empresas não responderam aos pedidos de comentários.

Populações vulneráveis

No estudo sobre rostos uigures publicado por Wiley, os pesquisadores não reuniram fotos online, mas disseram que tiraram fotos de mais de 300 estudantes uigures, coreanos e tibetanos de 18 a 22 anos na Universidade Dalian Minzu, no nordeste da China. onde alguns dos cientistas trabalharam. Meses após a publicação do estudo, os autores adicionaram uma nota para dizer que os alunos consentiram com isso. Mas as afirmações dos pesquisadores não amenizam as preocupações éticas, diz Yves Moreau, biólogo computacional da Universidade Católica de Leuven. Ele enviou a Wiley um pedido para retirar o trabalho no ano passado, junto com o grupo de defesa Tech Inquiry com sede em Toronto.

É improvável que os alunos tenham sido informados o suficiente sobre o propósito da pesquisa para terem dado consentimento verdadeiramente informado, diz Moreau. Mas mesmo que eles consentiram livremente, ele argumenta, os abusos dos direitos humanos em Xinjiang significam que Wiley deveria retirar o estudo para evitar dar ao trabalho crédito acadêmico.

Moreau catalogou dezenas de artigos sobre as populações uigures, incluindo trabalhos de reconhecimento facial e estudos que reuniram o DNA do povo uigur. Em dezembro, ele escreveu um artigo de opinião na Nature pedindo que todo trabalho antiético em pesquisa biométrica fosse retirado.

Sua campanha teve algum impacto, mas não tanto quanto ele esperava. Os editores dizem que a questão principal é verificar se os participantes nos estudos deram consentimento informado. A Springer Nature, por exemplo, disse em dezembro de 2019 que investigaria artigos de preocupação sobre grupos vulneráveis ao longo dessas linhas, e que atualizou suas orientações para editores e autores sobre a necessidade de obter consentimento explícito e informado em estudos que envolvem clínica, dados biomédicos ou biométricos de pessoas. Este ano, a editora retirou dois artigos sobre sequenciamento de DNA porque os autores admitiram que não haviam pedido consentimento ao povo uigur e expressou preocupação em outros 28.

Wiley também se concentrou no consentimento informado. Em novembro passado, a editora disse a Moreau and Tech Inquiry que estava satisfeita com a disponibilidade de formulários de consentimento e aprovação da universidade para o estudo de Dalian e, portanto, manteve a pesquisa, que sentiu que poderia ser firmemente separada das ações em Xinjiang. “Estamos cientes da perseguição às comunidades uigur”, disse Wiley. “No entanto, este artigo é sobre uma tecnologia específica e não uma aplicação dessa tecnologia.”

Em dezembro, no entanto, a editora abriu uma investigação formal, depois que a Curtin University, em Perth, Austrália, onde um dos autores está baseado, também pediu uma retratação, dizendo que concordava que o trabalho era eticamente indefensável. Este ano, Wiley adicionou uma nota do editor dizendo que o artigo “parece estar em conformidade com os padrões aceitáveis para a realização de pesquisas em seres humanos”. Em setembro, depois que Moreau investigou os estudos anteriores dos autores sobre o reconhecimento facial em uigures e apontou aparentes inconsistências no ano em que os conjuntos de dados foram coletados, Wiley expressou preocupação no estudo, dizendo que não estava claro quando a coleta de dados havia ocorrido.

O editor disse à Nature que agora considera o assunto encerrado após uma investigação completa – mas nem todos os envolvidos estão contentes. “A Curtin University afirma que o artigo deve ser retratado”, disse o vice-reitor Chris Moran à Nature. Ele disse que a universidade ainda está investigando o trabalho.

Wiley diz que depois de suas conversas com Moreau, atualizou suas diretrizes de integridade para garantir que os padrões esperados para consentimento informado sejam atendidos e descritos em artigos. Outros editores afirmam que também fizeram ajustes. O IEEE diz que em setembro aprovou uma política segundo a qual os autores de artigos sobre pesquisas envolvendo seres humanos ou animais devem confirmar se tiveram a aprovação de um IRB ou revisão local equivalente; os editores determinam se a pesquisa (em biometria ou outras áreas) envolve seres humanos.

Mas Moreau diz que o foco dos editores nos detalhes do consentimento é muito restrito e que eles também devem se posicionar sobre a ética mais ampla da pesquisa. “Estamos falando sobre abusos massivos dos direitos humanos”, diz ele. “Em algum momento, os editores ocidentais devem dizer que existem algumas linhas de base acima das quais eles não vão.” Ele sugere que os editores devem estabelecer comitês de ética independentes que podem dar opiniões quando questões como essas surgirem. (Nenhum editor questionado pela Nature disse que tinha dado esse passo.) Universidades e pesquisadores que desaprovam os abusos dos direitos humanos também poderiam fazer mais para expressar isso, abandonando suas associações com empresas de tecnologia questionáveis, diz Kate Crawford, codiretora do AI Now Institute da New York University.

No ano passado, houve um crescente escrutínio das parcerias das universidades com empresas ou programas de pesquisa ligados à vigilância em massa em Xinjiang. O Massachusetts Institute of Technology (MIT) em Cambridge, por exemplo, disse que revisaria seu relacionamento com a empresa de tecnologia SenseTime, com sede em Hong Kong, depois que o governo dos EUA – no meio de uma guerra comercial com a China – colocou a empresa e outros chineses na lista negra Empresas de IA, como a Megvii em Pequim, por causa de suas supostas contribuições para violações dos direitos humanos em Xinjiang. Em 2018, SenseTime e MIT anunciaram que formaram uma “aliança sobre inteligência artificial”; O MIT diz que o SenseTime forneceu uma quantia não revelada à universidade, sem quaisquer restrições sobre como seria usada, e que a universidade não a devolverá.

Tanto a Megvii quanto a SenseTime contestam a lista negra dos EUA. SenseTime afirma que sua tecnologia “nunca foi aplicada para fins antiéticos” e a Megvii afirma que exige que seus clientes “não utilizem nossa tecnologia ou soluções como arma para fins ilegais”.

As conferências acadêmicas também têm sido controversas. A Conferência Chinesa sobre Reconhecimento Biométrico (CCBR) foi realizada na capital de Xinjiang, Ürümqi, em 2018. Anil Jain, um cientista da computação da Michigan State University em East Lansing, fez parte do conselho consultivo da conferência e viajou até lá para fazer um discurso. Alguns pesquisadores de IA, incluindo Toby Walsh da University of New South Wales em Sydney, Austrália, mais tarde criticaram Jain por isso em histórias relatadas pela revista Coda, de Nova York.

A revista Coda também observou que a Springer Nature patrocinou a conferência; a empresa disse que seu papel se limitava a publicar anais da CCBR e que havia reforçado seus requisitos para que os organizadores da conferência cumprissem as políticas editoriais da editora depois que preocupações foram levantadas sobre o conteúdo anterior. E Jain desafiou a crítica, dizendo à Nature que participar de conferências na China “não significa que … participantes de conferências internacionais, como eu, toleram essas atrocidades contra as minorias”. Para o crescimento da vigilância, não deve haver razão para “restringir o intercâmbio científico”, disse ele.

Jain permanece no conselho consultivo para CCBR 2020-21; A Springer Nature ainda está publicando os resumos da conferência. E as principais conferências internacionais de visão computacional continuaram a aceitar o patrocínio de empresas chinesas. Logo após a lista negra, a SenseTime e a Megvii patrocinaram a Conferência Internacional de Visão Computacional de 2019 e a Megvii patrocinou a Conferência de 2020 sobre Visão Computacional e Reconhecimento de Padrões, embora seu logotipo tenha sido removido do site da conferência após a reunião. “As conferências devem evitar patrocinadores acusados de permitir abusos dos direitos humanos”, reitera Walsh. No entanto, ele observa que, no ano passado, a organização não governamental Human Rights Watch na cidade de Nova York retirou as acusações iniciais de que a tecnologia de reconhecimento facial da Megvii estava envolvida em um aplicativo usado em Xinjiang. Os organizadores da conferência não responderam a um pedido de comentário.

Pontos de verificação éticos

Projetos de pesquisa questionáveis também surgiram nos Estados Unidos. Em 5 de maio, a Harrisburg University, na Pensilvânia, postou um comunicado à imprensa declarando que os pesquisadores desenvolveram um software de reconhecimento facial “capaz de prever se alguém provavelmente será um criminoso”, com “80% de precisão e nenhum preconceito racial”. O anúncio desencadeou uma onda de críticas, assim como estudos anteriores que remetem ao trabalho desacreditado de fisionomistas do século XIX. Um notório estudo de 2016 relatou que um algoritmo de aprendizado de máquina pode detectar a diferença entre as imagens de não criminosos e as de criminosos condenados fornecidas por um departamento de polícia chinês.

A Harrisburg University retirou seu comunicado de imprensa em 6 de maio após o protesto, mas deixou uma dúvida pendente: o comunicado de imprensa dizia que o trabalho seria publicado pela Springer Nature em uma série de livros (que a editora posteriormente negou). Em 22 de junho, mais de 2.400 acadêmicos assinaram uma carta de um grupo chamado Coalition for Critical Technology (CCT), pedindo à Springer Nature que não publicasse o trabalho e pedindo a todos os editores que se abstenham de publicar estudos semelhantes.

A carta apontou que tais estudos são baseados em ciência doentia. Ele também observou que as ferramentas algorítmicas que informam à polícia onde ou quem é o alvo tendem a fornecer um verniz científico para métodos automatizados que apenas exacerbam os preconceitos existentes no sistema de justiça criminal. Três dias antes, mais de 1.400 matemáticos americanos escreveram uma carta pedindo a seus colegas que parassem de colaborar com a polícia em algoritmos que afirmam ajudar a reduzir o crime, devido a preocupações com o racismo sistêmico nas agências de aplicação da lei dos EUA.

Springer Nature disse que o trabalho nunca foi aceito para publicação: ele foi submetido a uma conferência e rejeitado após revisão por pares. (Os autores e a Harrisburg University recusaram-se a comentar.)

A Springer Nature já estava sendo criticada por outro artigo, publicado em janeiro no Journal of Big Data, sobre a detecção de “tendência criminosa” em fotos de criminosos e não criminosos. Depois que pesquisadores do IEEE entraram em contato com questões éticas, Margeret Hall, co-autora do artigo na Universidade de Nebraska Omaha, pediu em junho que o artigo fosse retirado. Hall diz que o papel agora recolhido era “indefensável”. Springer Nature diz que a revista revisou seus processos e agora exige que os autores incluam declarações sobre aprovações éticas e consentimento ao enviar manuscritos.

Levantamento da natureza

Para ter uma ideia mais ampla das visões acadêmicas sobre a ética do reconhecimento facial, a Nature entrevistou este ano 480 pesquisadores que publicaram artigos sobre reconhecimento facial, IA e ciência da computação. Em algumas perguntas, os entrevistados mostraram uma preferência clara. Quando questionados sobre suas opiniões sobre estudos que aplicam métodos de reconhecimento facial para reconhecer ou prever características pessoais (como gênero, identidade sexual, idade ou etnia) a partir da aparência, cerca de dois terços disseram que tais estudos deveriam ser feitos apenas com o consentimento informado daqueles cujos rostos foram usados, ou após discussão com representantes de grupos que podem ser afetados (ver ‘Reconhecimento facial: uma pesquisa sobre ética’).

Mas em outras questões, os acadêmicos estavam divididos. Cerca de 40% dos cientistas da pesquisa achavam que os pesquisadores deveriam obter consentimento informado dos indivíduos antes de usar seus rostos em um conjunto de dados de reconhecimento facial, mas mais da metade sentiu que isso não era necessário. O dilema dos pesquisadores é que é difícil ver como eles podem treinar algoritmos de reconhecimento facial precisos sem vastos conjuntos de dados de fotos, diz Sébastien Marcel, que lidera um grupo de biometria no Instituto de Pesquisa Idiap em Martigny, Suíça. Ele acha que os pesquisadores devem obter consentimento informado – mas, na prática, não. Seu próprio grupo não vasculha a web em busca de imagens, mas usa conjuntos de dados de imagens online que outros compilaram. “Muitos pesquisadores não querem ouvir sobre isso: eles consideram que não é problema deles”, diz ele.

Ed Gerstner, diretor de política de periódicos da Springer Nature, disse que a editora estava considerando o que poderia fazer para desencorajar o “uso contínuo” de bancos de dados de imagens que não têm consentimento explícito para seu uso em pesquisas das pessoas nas imagens.

A pesquisa da Nature também perguntou aos pesquisadores se eles achavam que a pesquisa de reconhecimento facial em populações vulneráveis – como refugiados ou grupos minoritários que estavam sob vigilância pesada – poderia ser eticamente questionável, mesmo se os cientistas tivessem obtido consentimento informado. No geral, 71% concordaram; alguns observaram que pode ser impossível determinar se o consentimento das populações vulneráveis foi informado, tornando-o potencialmente sem valor.

Alguns dos que discordaram, no entanto, tentaram estabelecer uma distinção entre a pesquisa acadêmica e como o reconhecimento facial é usado. O foco deve ser condenar e restringir as aplicações antiéticas do reconhecimento facial, e não restringir a pesquisa, disseram eles.

Os eticistas consideram essa distinção ingênua. “Essa é a mentalidade de “Eu sou apenas um engenheiro” e já passamos disso”, diz Karen Levy, socióloga da Universidade Cornell em Ithaca, Nova York, que trabalha com ética da tecnologia.

Alguns dos entrevistados na China disseram que ficaram ofendidos com a pergunta. “Não se deve dizer que em Xinjiang alguns grupos estão detidos em campos”, escreveu um. Pouco menos da metade dos 47 entrevistados chineses achavam que os estudos sobre grupos vulneráveis poderiam ser eticamente questionáveis mesmo se os cientistas tivessem obtido consentimento, uma proporção menor do que os entrevistados dos Estados Unidos e da Europa (ambos acima de 73%).

Um pesquisador chinês-americano de IA que não quis ser identificado disse que o problema era uma divisão cultural na área. “O número de pesquisadores chineses nas principais conferências que apoiam ativamente a censura e os campos de concentração de Xinjiang me preocupa muito. Esses grupos têm contato mínimo com a mídia não censurada e tendem a evitar o contato com aqueles que não falam mandarim, especialmente sobre questões sociais como esta. Acredito que precisamos encontrar maneiras de nos envolver ativamente com esta comunidade”, escreveram.

A natureza perguntou aos pesquisadores o que a comunidade científica deveria fazer a respeito de estudos eticamente questionáveis. A resposta mais popular foi que, durante a revisão por pares, os autores de artigos de reconhecimento facial deveriam ser questionados explicitamente sobre a ética de seus estudos. A pesquisa também perguntou se a pesquisa que usa software de reconhecimento facial deve exigir a aprovação prévia de órgãos de ética, como IRBs, que consideram a pesquisa com seres humanos. Quase metade acha que deveria, e outro quarto disse que depende da pesquisa.

Reflexão ética

Pesquisadores que trabalham com tecnologia que reconhece ou analisa rostos apontam que ela tem muitos usos, como encontrar crianças perdidas, rastrear criminosos, acessar smartphones e caixas eletrônicos de forma mais conveniente, ajudar robôs a interagir com humanos, reconhecendo suas identidades e emoções e, em alguns estudos médicos, para ajudar a diagnosticar ou rastrear remotamente os participantes que consentiram. “Existem várias aplicações legais e legítimas de reconhecimento facial e biométrico de que precisamos em nossa sociedade”, disse Jain.

Mas os pesquisadores também devem reconhecer que uma tecnologia que pode identificar ou classificar pessoas remotamente sem seu conhecimento é fundamentalmente perigosa – e deve tentar resistir a ser usada para controlar ou criminalizar pessoas, dizem alguns cientistas. “A comunidade de IA sofre por não ver como seu trabalho se encaixa em uma longa história da ciência sendo usada para legitimar a violência contra pessoas marginalizadas e para estratificar e separar pessoas”, diz Chelsea Barabas, que estuda tomada de decisão algorítmica no MIT e ajudou a formar o CCT este ano. “Se você projeta um algoritmo de reconhecimento facial para pesquisa médica sem pensar em como ele poderia ser usado pela polícia, por exemplo, você está sendo negligente”, diz ela.

Algumas organizações estão começando a exigir que os pesquisadores tenham mais cuidado. Uma das principais reuniões do campo de IA, a conferência NeurIPS (Neural Information Processing Systems), está exigindo tais considerações éticas pela primeira vez este ano. Os cientistas que enviam artigos devem adicionar uma declaração abordando questões éticas e possíveis resultados negativos de seu trabalho. “Não vai resolver o problema, mas é um passo na direção certa”, diz David Ha, pesquisador de IA do Google em Tóquio. A revista Nature Machine Intelligence também está testando uma abordagem na qual pede aos autores de alguns artigos de aprendizado de máquina que incluam uma declaração considerando impactos sociais e questões éticas mais amplas, diz Gerstner.

Levy tem esperança de que os acadêmicos em reconhecimento facial estejam acordando para as implicações daquilo em que trabalham – e o que isso pode significar para sua reputação se não erradicarem as questões éticas da área. “Parece um momento de verdadeiro despertar na comunidade científica”, diz ela. “As pessoas estão mais conscientes das maneiras pelas quais as tecnologias com as quais trabalham podem ser utilizadas politicamente – e elas sentem isso visceralmente.”

Publicado em 22/11/2020 00h20

Artigo original:

Estudo original: