Não há boas evidências de que as expressões faciais revelem os sentimentos de uma pessoa. Mas as grandes empresas de tecnologia querem que você acredite no contrário.

Em um remoto posto avançado nas montanhas da Papua Nova Guiné, um jovem psicólogo americano chamado Paul Ekman chegou com uma coleção de cartões de memória e uma nova teoria. Era 1967 e Ekman ouvira dizer que o povo Fore de Okapa estava tão isolado do mundo exterior que seriam seus objetos de teste ideais.

Como os pesquisadores ocidentais antes dele, Ekman tinha vindo para Papua Nova Guiné para extrair dados da comunidade indígena. Ele estava reunindo evidências para sustentar uma hipótese controversa: que todos os humanos exibem um pequeno número de emoções universais, ou afetos, que são inatos e iguais em todo o mundo. Por mais de meio século, essa afirmação permaneceu controversa, disputada entre psicólogos, antropólogos e tecnólogos. No entanto, tornou-se uma semente para um mercado em crescimento que valerá cerca de US $ 56 bilhões em 2024. Esta é a história de como o reconhecimento de afeto passou a fazer parte da indústria de inteligência artificial e os problemas que isso apresenta.

Quando Ekman chegou aos trópicos de Okapa, ele fez experimentos para avaliar como os Fore reconheciam as emoções. Como os Fore tinham contato mínimo com ocidentais e a mídia de massa, Ekman teorizou que seu reconhecimento e exibição de expressões essenciais provariam que tais expressões eram universais. Seu método era simples. Ele mostrava a eles cartões de expressões faciais e veria se eles descreviam a emoção como ele o fazia. Nas próprias palavras de Ekman, “Tudo o que eu estava fazendo era mostrar fotos engraçadas.” Mas Ekman não tinha treinamento em história, língua, cultura ou política Fore. Suas tentativas de conduzir seus experimentos com cartões flash usando tradutores fracassaram; ele e seus súditos estavam exaustos com o processo, que ele descreveu como arrancar dentes. Ekman deixou Papua Nova Guiné, frustrado com sua primeira tentativa de pesquisa intercultural sobre expressão emocional. Mas isso seria apenas o começo.

Hoje, as ferramentas de reconhecimento de afeto podem ser encontradas em sistemas de segurança nacional e em aeroportos, em empresas de educação e contratações, em softwares que pretendem detectar doenças psiquiátricas e programas de policiamento que afirmam prever a violência. A alegação de que o estado interior de uma pessoa pode ser avaliado com precisão pela análise do rosto dessa pessoa tem como premissa evidências duvidosas. Uma revisão sistemática de 2019 da literatura científica sobre inferir emoções a partir dos movimentos faciais, liderada pela psicóloga e neurocientista Lisa Feldman Barrett, descobriu que não há evidências confiáveis de que você pode prever com precisão o estado emocional de alguém dessa maneira. “Não é possível inferir com segurança a felicidade de um sorriso, a raiva de uma carranca ou a tristeza de uma carranca, como muito da tecnologia atual tenta fazer ao aplicar o que se acredita erroneamente ser fatos científicos”, conclui o estudo. Então, por que a ideia de que existe um pequeno conjunto de emoções universais, prontamente interpretadas a partir do rosto de uma pessoa, se tornou tão aceita no campo da IA?

Para entender isso, é necessário rastrear a história complexa e os incentivos por trás de como essas ideias se desenvolveram, muito antes das ferramentas de detecção de emoções de IA serem incorporadas à infraestrutura da vida cotidiana.

A ideia de reconhecimento automatizado de afeto é tão atraente quanto lucrativa. As empresas de tecnologia capturaram imensos volumes de imagens de nível superficial de expressões humanas – incluindo bilhões de selfies do Instagram, retratos do Pinterest, vídeos do TikTok e fotos do Flickr. Assim como o reconhecimento facial, o reconhecimento de afeto tornou-se parte da infraestrutura central de muitas plataformas, desde as maiores empresas de tecnologia até as pequenas empresas iniciantes.

Enquanto o reconhecimento facial tenta identificar um indivíduo específico, o reconhecimento de afeto visa detectar e classificar as emoções por meio da análise de qualquer rosto. Esses sistemas já influenciam como as pessoas se comportam e como as instituições sociais funcionam, apesar da falta de evidências científicas substanciais de que funcionam. Os sistemas automatizados de detecção de afeto agora são amplamente implantados, principalmente na contratação. A empresa de contratação de AI HireVue, que pode listar Goldman Sachs, Intel e Unilever entre seus clientes, usa o aprendizado de máquina para inferir a adequação das pessoas para um trabalho. Em 2014, a empresa lançou seu sistema de IA para extrair microexpressões, tom de voz e outras variáveis de entrevistas de emprego em vídeo, que foi usado para comparar candidatos a empregos com os de melhor desempenho de uma empresa. Depois de consideráveis críticas de acadêmicos e grupos de direitos civis, ele abandonou a análise facial em 2021, mas manteve o tom de voz como um critério de avaliação. Em janeiro de 2016, a Apple adquiriu a start-up Emotient, que afirmava ter produzido um software capaz de detectar emoções a partir de imagens de rostos. Talvez a maior dessas start-ups seja a Affectiva, uma empresa sediada em Boston que surgiu a partir de trabalhos acadêmicos feitos no MIT.

A Affectiva codificou uma variedade de aplicativos relacionados à emoção, principalmente usando técnicas de aprendizado profundo. Essas abordagens incluem detectar motoristas distraídos e “arriscados” nas estradas e medir as respostas emocionais dos consumidores à publicidade. A empresa construiu o que chama de maior banco de dados de emoções do mundo, composto por mais de 10 milhões de expressões de pessoas de 87 países. Sua coleção monumental de vídeos foi etiquetada à mão por crowdworkers baseados principalmente no Cairo.

Fora do setor de start-ups, gigantes da IA, como Amazon, Microsoft e IBM, todos desenvolveram sistemas para detecção de emoções. A Microsoft oferece detecção de emoção percebida em sua API Face, identificando “raiva, desprezo, repulsa, medo, felicidade, neutro, tristeza e surpresa”, enquanto a ferramenta Rekognition da Amazon proclama de forma semelhante que pode identificar o que caracteriza como “todas as sete emoções” e “Medir como essas coisas mudam ao longo do tempo, como construir uma linha do tempo das emoções de um ator.”

Os sistemas de reconhecimento de emoções compartilham um conjunto semelhante de projetos e suposições fundamentais: que existe um pequeno número de categorias emocionais distintas e universais, que involuntariamente revelamos essas emoções em nossos rostos e que elas podem ser detectadas por máquinas. Esses artigos de fé são tão aceitos em alguns campos que pode parecer estranho até mesmo notá-los, quanto mais questioná-los. Mas se olharmos como as emoções passaram a ser taxonomizadas – ordenadas e rotuladas de maneira ordenada – veremos que as questões estão à espreita em cada esquina.

A pesquisa de kman começou com um encontro feliz com Silvan Tomkins, então um psicólogo estabelecido em Princeton que publicou o primeiro volume de sua magnum opus, Affect Imagery Consciousness, em 1962. O trabalho de Tomkins sobre afeto teve uma grande influência em Ekman, que dedicou muito de sua carreira para estudar suas implicações. Um aspecto em particular desempenhou um papel extraordinário: a ideia de que se os afetos fossem um conjunto inato de respostas evolutivas, eles seriam universais e, portanto, reconhecíveis em todas as culturas. Esse desejo de universalidade tem uma influência importante sobre o motivo pelo qual essa teoria é amplamente aplicada nos sistemas de reconhecimento de emoções de IA hoje. A teoria poderia ser aplicada em qualquer lugar, uma simplificação da complexidade que era facilmente replicável em escala.

Na introdução de Affect Imagery Consciousness, Tomkins enquadrou sua teoria dos afetos universais de base biológica como uma abordagem de uma crise aguda de soberania humana. Ele estava desafiando o desenvolvimento do behaviorismo e da psicanálise, duas escolas de pensamento que ele acreditava tratar a consciência como um mero subproduto que estava a serviço de outras forças. Ele observou que a consciência humana tinha “sido desafiada e reduzida repetidamente, primeiro por Copérnico” – que deslocou o homem do centro do universo – “depois por Darwin” – cuja teoria da evolução destruiu a ideia de que os humanos foram criados na imagem de um Deus cristão – “e acima de tudo por Freud” – que descentrou a consciência e a razão humanas como forças motrizes por trás de nossas motivações. Tomkins continuou: “O paradoxo do controle máximo sobre a natureza e controle mínimo sobre a natureza humana é em parte um derivado da negligência do papel da consciência como mecanismo de controle.” Para simplificar, a consciência pouco nos diz sobre por que sentimos e agimos dessa maneira. Esta é uma afirmação crucial para todos os tipos de aplicações posteriores da teoria dos afetos, que enfatizam a incapacidade dos humanos de reconhecer tanto o sentimento quanto a expressão dos afetos. Se nós, como humanos, somos incapazes de realmente detectar o que estamos sentindo, talvez os sistemas de IA possam fazer isso por nós?

A teoria dos afetos de Tomkins foi sua maneira de abordar o problema da motivação humana. Ele argumentou que a motivação era governada por dois sistemas: afetos e impulsos. Tomkins propôs que os impulsos tendem a estar intimamente associados às necessidades biológicas imediatas, como fome e sede. Eles são instrumentais; a dor da fome pode ser curada com comida. Mas o sistema primário que governa a motivação e o comportamento humanos é o dos afetos, envolvendo sentimentos positivos e negativos. Os afetos, que desempenham o papel mais importante na motivação humana, amplificam os sinais de impulso, mas são muito mais complexos. Por exemplo, é difícil saber as causas precisas que levam um bebê a chorar, expressando o afeto angústia-angústia.

Como podemos saber algo sobre um sistema no qual as conexões entre causa e efeito, estímulo e resposta são tão tênues e incertas? Tomkins propôs uma resposta: “Os efeitos primários. . . parecem estar inatamente relacionados de um modo um a um com um sistema de órgãos que é extraordinariamente visível” – a saber, o rosto. Ele encontrou precedentes para essa ênfase na expressão facial em duas obras publicadas no século 19: A Expressão das Emoções no Homem e nos Animais, de Charles Darwin, de 1872, e um volume obscuro do neurologista francês Guillaume-Benjamin-Amand Duchenne de Boulogne, de 1862.

Tomkins presumiu que a exibição facial de afetos era uma característica humana universal. “Afetos”, acreditava Tomkins, “são conjuntos de respostas musculares, vasculares e glandulares localizadas na face e também amplamente distribuídas pelo corpo, que geram feedback sensorial. . . Esses conjuntos organizados de respostas são acionados em centros subcorticais onde ‘programas’ específicos para cada efeito distinto são armazenados” – um uso inicial de uma metáfora computacional para um sistema humano. Mas Tomkins reconheceu que a interpretação das manifestações afetivas depende de fatores individuais, sociais e culturais. Ele admitiu que havia “dialetos” muito diferentes da linguagem facial nas diferentes sociedades. Até mesmo o antepassado da pesquisa de afeto levantou a possibilidade de que a interpretação das manifestações faciais dependa do contexto social e cultural.

Dado que as expressões faciais são culturalmente variáveis, usá-las para treinar sistemas de aprendizado de máquina inevitavelmente combinaria todos os tipos de contextos, sinais e expectativas diferentes. O problema para Ekman, e mais tarde para o campo da visão computacional, era como reconciliar essas tensões.

Em meados da década de 1960, a oportunidade bateu à porta de Ekman na forma de uma grande doação do que agora é chamado de Agência de Projetos de Pesquisa Avançada de Defesa (DARPA), um braço de pesquisa do Departamento de Defesa. O considerável apoio financeiro da DARPA permitiu que Ekman começasse seus primeiros estudos para provar a universalidade da expressão facial. Em geral, esses estudos seguiram um projeto que seria copiado nos primeiros laboratórios de IA. Ele duplicou em grande parte os métodos de Tomkins, mesmo usando as fotografias de Tomkins para testar assuntos do Chile, Argentina, Brasil, Estados Unidos e Japão. Os participantes foram apresentados a fotografias de expressões faciais postas, selecionadas pelos designers para exemplificar ou expressar um afeto particularmente “puro”, como medo, surpresa, raiva, felicidade, tristeza e repulsa. Os sujeitos foram então solicitados a escolher entre essas categorias de afeto e rotular a imagem posta. A análise mediu o grau de correlação entre os rótulos escolhidos pelos sujeitos e os escolhidos pelos designers.

Desde o início, a metodologia teve problemas. O formato de resposta de escolha forçada de Ekman seria posteriormente criticado por alertar os sujeitos sobre as conexões que os designers já haviam feito entre as expressões faciais e as emoções. Além disso, o fato de essas emoções serem falsas levantaria questões sobre a validade dos resultados.

A ideia de que estados internos podem ser inferidos de forma confiável a partir de signos externos tem uma longa história. Ela se origina em parte da história da fisionomia, que teve como premissa estudar as características faciais de uma pessoa para obter indicações de seu caráter. Aristóteles acreditava que “é possível julgar o caráter dos homens por sua aparência física. . . pois foi assumido que corpo e alma são afetados juntos.” Os gregos também usavam a fisionomia como uma forma primitiva de classificação racial, aplicada ao “próprio gênero homem, dividindo-o em raças, na medida em que diferem em aparência e caráter (por exemplo, egípcios, trácios e citas)”.

A fisionomia da cultura ocidental atingiu seu auge durante os séculos 18 e 19, quando era vista como parte das ciências anatômicas. Uma figura chave nessa tradição foi o pastor suíço Johann Kaspar Lavater, que escreveu Ensaios sobre a fisionomia: Para a promoção do conhecimento e do amor à humanidade, publicado originalmente em alemão em 1789. Lavater adotou as abordagens da fisionomia e as combinou com as mais recentes conhecimento científico. Ele acreditava que a estrutura óssea era uma conexão subjacente entre a aparência física e o tipo de caráter. Se as expressões faciais eram fugazes, os crânios pareciam oferecer um material mais sólido para inferências fisionômicas. A medição do crânio era uma técnica popular na ciência racial e era usada para apoiar o nacionalismo, a supremacia branca e a xenofobia. Este trabalho foi elaborado de forma infame ao longo do século 19 por frenólogos como Franz Joseph Gall e Johann Gaspar Spurzheim, bem como na criminologia científica através da obra de Cesare Lombroso.

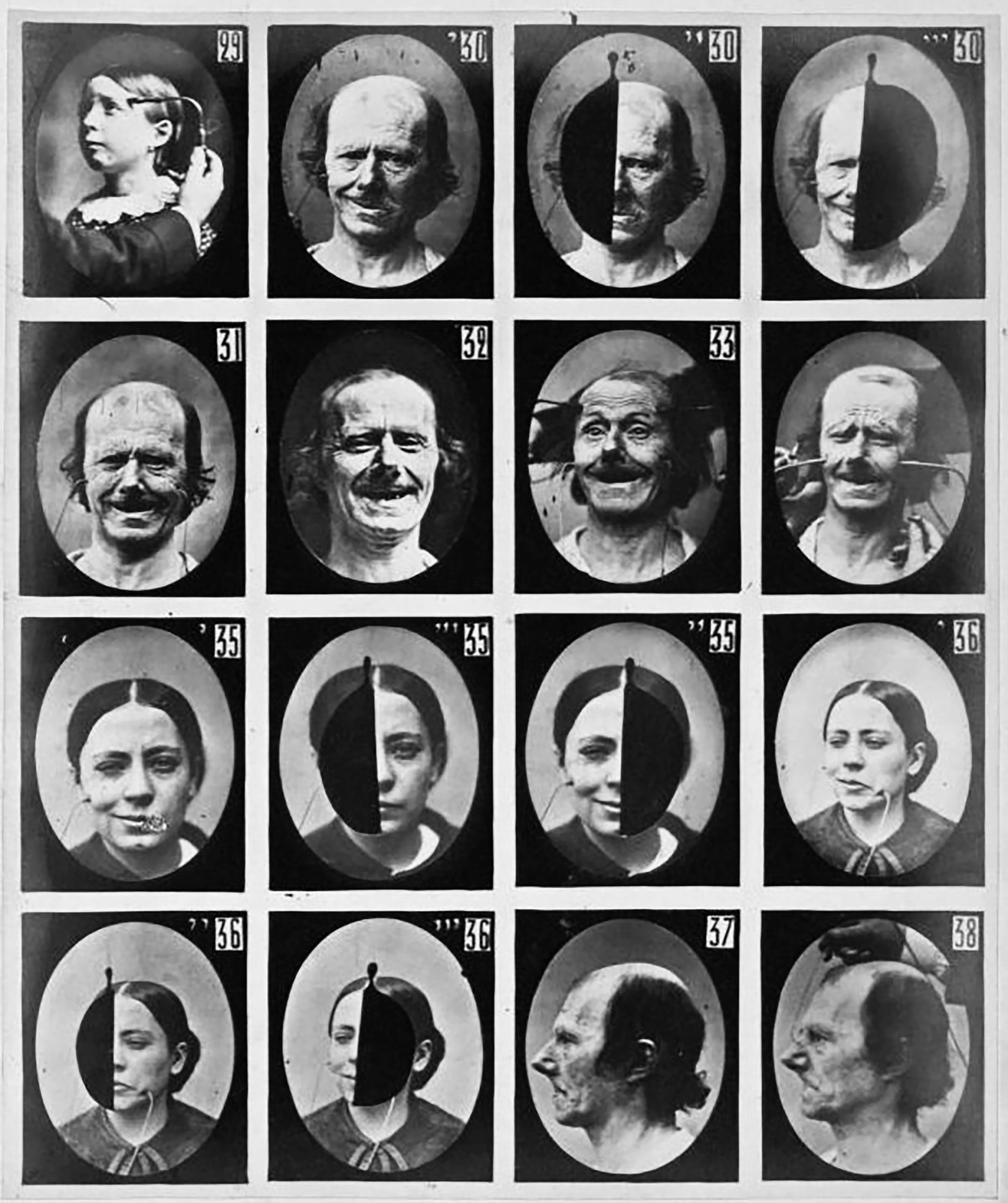

Mas foi o neurologista francês Duchenne, descrito por Ekman como um “observador maravilhosamente talentoso”, que codificou o uso da fotografia e de outros meios técnicos no estudo de rostos humanos. Em Mécanisme de la physionomie humaine, Duchenne lançou bases importantes para Darwin e Ekman, conectando ideias mais antigas da fisionomia e frenologia com investigações mais modernas em fisiologia e psicologia. Ele substituiu as vagas afirmações sobre o caráter por uma investigação mais limitada da expressão e dos estados mentais e emocionais interiores.

Duchenne trabalhou em Paris no asilo Salpêtrière, que abrigava até 5.000 pessoas com uma ampla variedade de doenças mentais e neurológicas. Alguns se tornariam seus objetos de experimentos angustiantes, parte da longa tradição de experimentação médica e tecnológica nos mais vulneráveis, aqueles que não podem recusar. Duchenne, que era pouco conhecido na comunidade científica, decidiu desenvolver técnicas de choques elétricos para estimular movimentos musculares isolados no rosto das pessoas. Seu objetivo era construir uma compreensão anatômica e fisiológica mais completa da face. Duchenne usou esses métodos para estabelecer uma ponte entre a nova ciência psicológica e o estudo muito mais antigo dos sinais fisionômicos, ou paixões. Ele contou com os mais recentes avanços fotográficos, como o processamento de colódio, que permitiu tempos de exposição muito mais curtos, permitindo a Duchenne congelar movimentos musculares e expressões faciais em imagens.

Mesmo nesses estágios iniciais, os rostos nunca foram expressões humanas naturais ou sociais, mas simulações produzidas pela aplicação bruta de eletricidade nos músculos. Independentemente disso, Duchenne acreditava que o uso da fotografia e de outros sistemas técnicos transformariam o mole negócio da representação em algo objetivo e probatório, mais adequado ao estudo científico. Darwin elogiou as “fotografias magníficas” de Duchenne e incluiu reproduções em seu próprio trabalho.

Ekman seguiria Duchenne ao colocar a fotografia no centro de sua prática experimental. Ele acreditava que a fotografia em câmera lenta era essencial para sua abordagem, porque muitas expressões faciais operam nos limites da percepção humana. O objetivo era encontrar as chamadas microexpressões – minúsculos movimentos musculares do rosto.

Um dos planos ambiciosos de Ekman em sua pesquisa inicial era codificar um sistema para detectar e analisar expressões faciais. Em 1971, ele co-publicou uma descrição do que chamou de Técnica de Pontuação do Afeto Facial (FAST).

Baseando-se em fotografias posadas, a abordagem usou seis tipos emocionais básicos, em grande parte derivados das intuições de Ekman. Mas o FAST logo teve problemas quando outros cientistas encontraram expressões faciais não incluídas em sua tipologia. Então, Ekman decidiu basear sua próxima ferramenta de medição na musculatura facial, voltando aos estudos originais de eletrochoque de Duchenne. Ekman identificou cerca de 40 contrações musculares distintas no rosto e chamou os componentes básicos de cada expressão facial de “unidade de ação”. Após alguns testes e validação, Ekman e Wallace Friesen publicaram o Facial Action Coding System (FACS) em 1978; as edições atualizadas continuam a ser amplamente utilizadas.

Apesar de seu sucesso financeiro, o uso do FACS era muito trabalhoso. Ekman escreveu que levou de 75 a 100 horas para treinar usuários na metodologia FACS e uma hora para marcar um único minuto de filmagem facial. Esse desafio apresentava exatamente o tipo de oportunidade que o campo emergente da visão computacional estava ansioso para assumir.

À medida que o trabalho com o uso de computadores no reconhecimento de afetos começou a tomar forma, os pesquisadores reconheceram a necessidade de uma coleção de imagens padronizadas para fazer experiências. Um relatório da National Science Foundation de 1992 co-escrito por Ekman recomendou que “um banco de dados multimídia facilmente acessível, compartilhado pela comunidade diversificada de pesquisa facial, seria um recurso importante para a resolução e extensão de questões relativas à compreensão facial.” Em um ano, o Departamento de Defesa começou a financiar um programa para coletar fotos faciais. No final da década, os pesquisadores de aprendizado de máquina começaram a montar, rotular e tornar públicos os conjuntos de dados que conduzem grande parte da pesquisa de aprendizado de máquina atual. Laboratórios acadêmicos e empresas trabalharam em projetos paralelos, criando dezenas de bancos de dados de fotos. Por exemplo, pesquisadores em um laboratório na Suécia criaram Karolinska Directed Emotional Faces. Este banco de dados compreende imagens de indivíduos retratando expressões emocionais postas correspondentes às categorias de Ekman. Eles transformaram seus rostos em formas que correspondem a seis estados emocionais básicos: alegria, raiva, nojo, tristeza, surpresa e medo. Ao olhar para esses conjuntos de treinamento, é difícil não ser atingido por uma sensação de pantomima: Incrível surpresa! Alegria abundante! Medo paralisante! Esses assuntos estão literalmente criando emoções legíveis por máquinas.

À medida que o campo crescia em escala e complexidade, também cresciam os tipos de fotografias usadas no reconhecimento de afeto. Os pesquisadores começaram a usar o sistema FACS para rotular dados gerados não por expressões postas, mas por expressões faciais espontâneas, às vezes obtidas fora das condições de laboratório. O trabalho de Ekman teve uma influência profunda e abrangente. O New York Times descreveu Ekman como “o leitor facial mais famoso do mundo”, e a Time o nomeou uma das 100 pessoas mais influentes do mundo. Ele eventualmente consultaria clientes tão díspares quanto Dalai Lama, FBI, CIA, Serviço Secreto e o estúdio de animação Pixar, que queria criar representações mais realistas de rostos de desenhos animados. Suas ideias se tornaram parte da cultura popular, incluídas em best-sellers como Blink de Malcolm Gladwell e um drama de televisão, Lie to Me, no qual Ekman foi um consultor para o papel do personagem principal, aparentemente vagamente baseado nele.

Seu negócio prosperou: Ekman vendeu técnicas de detecção de fraude para agências como a Administração de Segurança de Transporte, que as usou para desenvolver o programa de Triagem de Passageiros por Técnicas de Observação (SPOT). O SPOT tem sido usado para monitorar as expressões faciais dos viajantes aéreos desde os ataques de 11 de setembro, em uma tentativa de detectar “automaticamente” terroristas. O sistema usa um conjunto de 94 critérios, todos supostamente sinais de estresse, medo ou engano. Mas procurar por essas respostas significa que alguns grupos ficam imediatamente em desvantagem. Qualquer pessoa estressada, desconfortável com o interrogatório ou que teve experiências negativas com a polícia e os guardas de fronteira pode pontuar mais alto. Isso cria suas próprias formas de definição de perfil racial. O programa SPOT foi criticado pelo Government Accountability Office e grupos de liberdades civis por seu preconceito racial e falta de metodologia científica. Apesar de seu preço de US $ 900 milhões, não há evidências de que produziu sucessos claros.

À medida que a fama de ekman se espalhava, o mesmo acontecia com o ceticismo de seu trabalho, com críticas surgindo de vários campos. Uma das primeiras críticas foi a antropóloga cultural Margaret Mead, que debateu Ekman sobre a questão da universalidade das emoções no final dos anos 1960. Mead não estava convencido da crença de Ekman em determinantes biológicos universais de comportamento que existem separadamente de fatores culturais altamente condicionados.

Cientistas de diferentes áreas juntaram-se ao coro ao longo das décadas. Nos anos mais recentes, os psicólogos James Russell e José-Miguel Fernández-Dols mostraram que os aspectos mais básicos da ciência permanecem incertos. Talvez o principal crítico da teoria de Ekman seja a historiadora da ciência Ruth Leys, que vê uma circularidade fundamental no método de Ekman. As fotografias posadas ou simuladas que ele usou foram consideradas como expressando um conjunto de estados afetivos básicos que estavam, Leys escreveu, “já livres de influência cultural”. Essas fotos foram então usadas para extrair rótulos de diferentes populações para demonstrar a universalidade das expressões faciais. A psicóloga e neurocientista Lisa Feldman Barrett expressa isso sem rodeios: ?As empresas podem dizer o que quiserem, mas os dados são claros. Eles podem detectar uma carranca, mas isso não é a mesma coisa que detectar raiva. ”

Mais preocupante ainda é que, no campo do estudo das emoções, os pesquisadores não chegaram a um consenso sobre o que uma emoção realmente é. O que são as emoções, como são formuladas dentro de nós e expressas, quais poderiam ser suas funções fisiológicas ou neurobiológicas, sua relação com os estímulos – tudo isso permanece teimosamente indefinido. Por que, com tantas críticas, a abordagem de “ler as emoções” do rosto de uma pessoa perdurou? Desde 1960, impulsionado por fundos significativos do Departamento de Defesa, vários sistemas foram desenvolvidos que são cada vez mais precisos na medição dos movimentos faciais. A teoria de Ekman parecia ideal para visão computacional porque poderia ser automatizada em grande escala. A teoria se ajusta ao que as ferramentas podem fazer.

Investimentos institucionais e corporativos poderosos foram feitos com base na validade percebida das teorias e metodologias de Ekman. Reconhecer que as emoções não são facilmente classificadas ou que não são detectáveis de forma confiável pelas expressões faciais pode prejudicar uma indústria em expansão. Muitos artigos de aprendizado de máquina citam Ekman como se esses problemas estivessem resolvidos, antes de prosseguir diretamente para os desafios de engenharia. As questões mais complexas de contexto, condicionamento, relacionalidade e cultura são freqüentemente ignoradas. O próprio Ekman disse que está preocupado com a forma como suas ideias estão sendo comercializadas, mas quando ele escreveu para empresas de tecnologia pedindo evidências de que seus programas de reconhecimento de emoções funcionam, ele não recebeu resposta.

Em vez de tentar construir mais sistemas que agrupem expressões em categorias legíveis por máquina, devemos questionar as origens dessas categorias em si, bem como suas consequências sociais e políticas. Por exemplo, esses sistemas são conhecidos por sinalizar os efeitos da fala das mulheres, particularmente das mulheres negras, diferentemente dos homens. Um estudo realizado na Universidade de Maryland mostrou que alguns softwares de reconhecimento facial interpretam os rostos negros como tendo emoções mais negativas do que os rostos brancos, registrando-os especificamente como mais raivosos e mais desdenhosos, mesmo quando controlando seu grau de sorriso.

Este é o perigo de automatizar o reconhecimento de emoções. Essas ferramentas podem nos levar de volta ao passado frenológico, quando afirmações espúrias eram usadas para apoiar os sistemas de poder existentes. As décadas de controvérsia científica em torno de inferir estados emocionais de forma consistente do rosto de uma pessoa enfatizam um ponto central: “detecção” de tamanho único não é a abordagem certa. As emoções são complicadas e se desenvolvem e mudam em relação às nossas culturas e histórias – todos os contextos múltiplos que vivem fora da estrutura da IA.

Mas já, os candidatos a emprego são julgados injustamente porque suas expressões faciais ou tons de voz não correspondem aos de outros funcionários. Os alunos são sinalizados na escola porque seus rostos parecem zangados e os clientes são questionados porque suas pistas faciais indicam que podem ser ladrões de lojas. Essas são as pessoas que arcarão com os custos de sistemas que não são apenas tecnicamente imperfeitos, mas baseados em metodologias questionáveis. Uma taxonomia restrita de emoções – desenvolvida a partir dos experimentos iniciais de Ekman – está sendo codificada em sistemas de aprendizado de máquina como um proxy para a complexidade infinita da experiência emocional no mundo.

Publicado em 06/05/2021 11h55

Artigo original:

Estudo original: