Treinar redes neurais para realizar tarefas, como reconhecer imagens ou navegar em carros autônomos, pode um dia exigir menos capacidade de computação e hardware graças a um novo dispositivo de neurônio artificial desenvolvido por pesquisadores da Universidade da Califórnia em San Diego. O dispositivo pode executar cálculos de rede neural usando 100 a 1000 vezes menos energia e área do que o hardware baseado em CMOS existente.

Os pesquisadores relatam seu trabalho em um artigo publicado em 18 de março na Nature Nanotechnology.

As redes neurais são uma série de camadas conectadas de neurônios artificiais, onde a saída de uma camada fornece a entrada para a próxima. A geração dessa entrada é feita aplicando-se um cálculo matemático denominado função de ativação não linear. Esta é uma parte crítica do funcionamento de uma rede neural. Mas a aplicação dessa função requer muito poder de computação e circuitos, porque envolve a transferência de dados para frente e para trás entre duas unidades separadas – a memória e um processador externo.

Agora, os pesquisadores da UC San Diego desenvolveram um dispositivo do tamanho de um nanômetro que pode realizar com eficiência a função de ativação.

“Os cálculos de rede neural em hardware ficam cada vez mais ineficientes à medida que os modelos de rede neural ficam maiores e mais complexos”, disse Duygu Kuzum, professor de engenharia elétrica e de computação na Escola de Engenharia da UC San Diego Jacobs. “Nós desenvolvemos um dispositivo de neurônio artificial em nanoescala único que implementa esses cálculos em hardware de maneira eficiente em termos de área e energia.”

O novo estudo, liderado por Kuzum e seu Ph.D. O estudante Sangheon Oh foi realizado em colaboração com um Centro de Pesquisa de Fronteira de Energia do DOE liderado pelo professor de física Ivan Schuller da UC San Diego, que se concentra no desenvolvimento de implementações de hardware de redes neurais artificiais com eficiência energética.

O dispositivo implementa uma das funções de ativação mais comumente usadas no treinamento de rede neural, chamada de unidade linear retificada. O que há de especial nessa função é que ela precisa de hardware que pode sofrer uma mudança gradual na resistência para funcionar. E é exatamente para isso que os pesquisadores da UC San Diego projetaram seu dispositivo – ele pode mudar gradualmente de um estado isolante para um estado condutor, e faz isso com a ajuda de um pouco de calor.

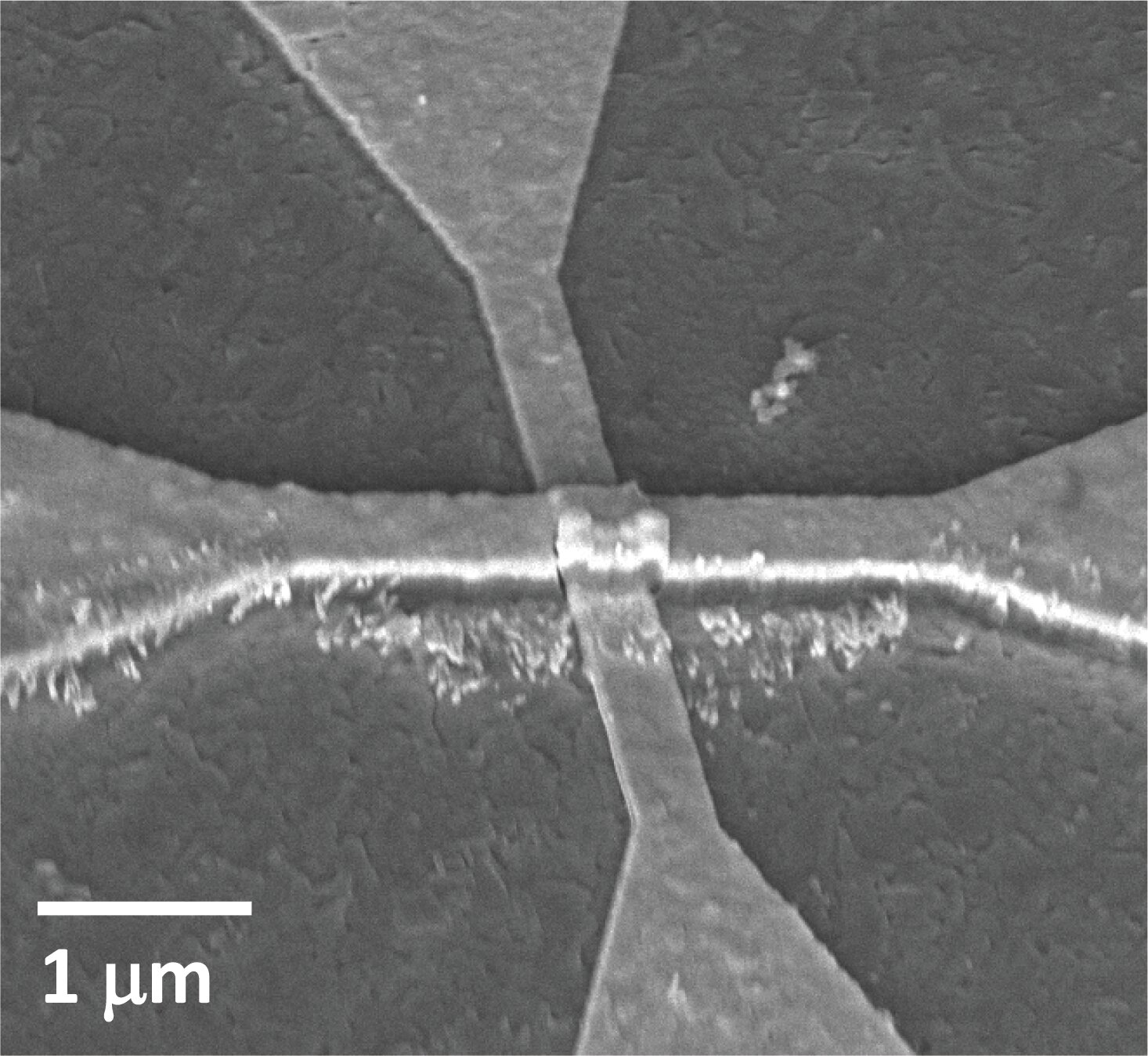

Essa opção é chamada de transição de Mott. Ele ocorre em uma camada de dióxido de vanádio de espessura nanométrica. Acima desta camada está um aquecedor de nanofios feito de titânio e ouro. Quando a corrente flui através do nanofio, a camada de dióxido de vanádio se aquece lentamente, causando uma troca lenta e controlada de isolante para condutor.

“Esta arquitetura de dispositivo é muito interessante e inovadora”, disse Oh, que é o primeiro autor do estudo. Normalmente, os materiais em uma transição de Mott passam por uma mudança abrupta de isolante para condutor porque a corrente flui diretamente através do material, explicou ele. “Neste caso, fazemos o fluxo de corrente através de um nanofio no topo do material para aquecê-lo e induzir uma mudança de resistência muito gradual.”

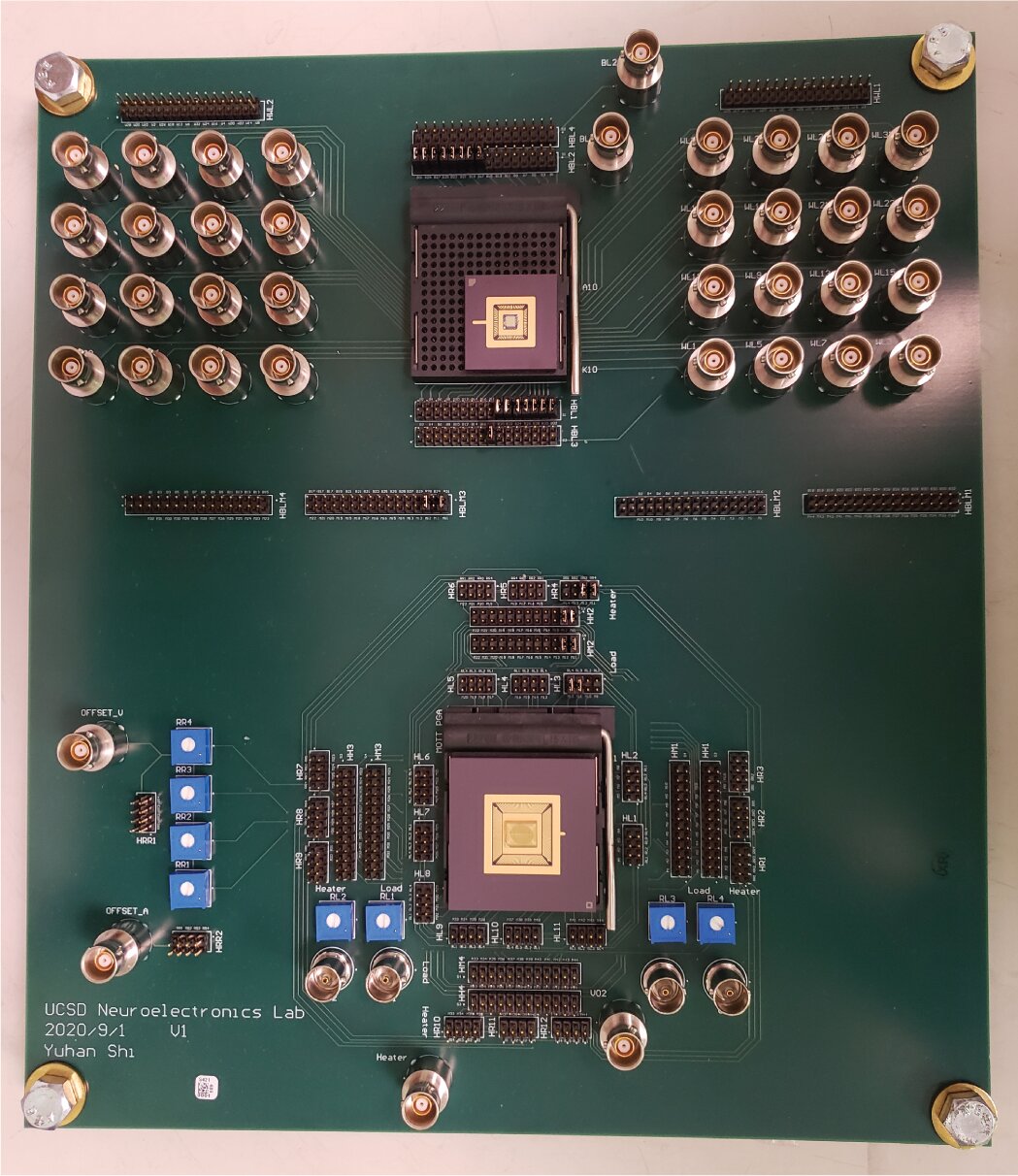

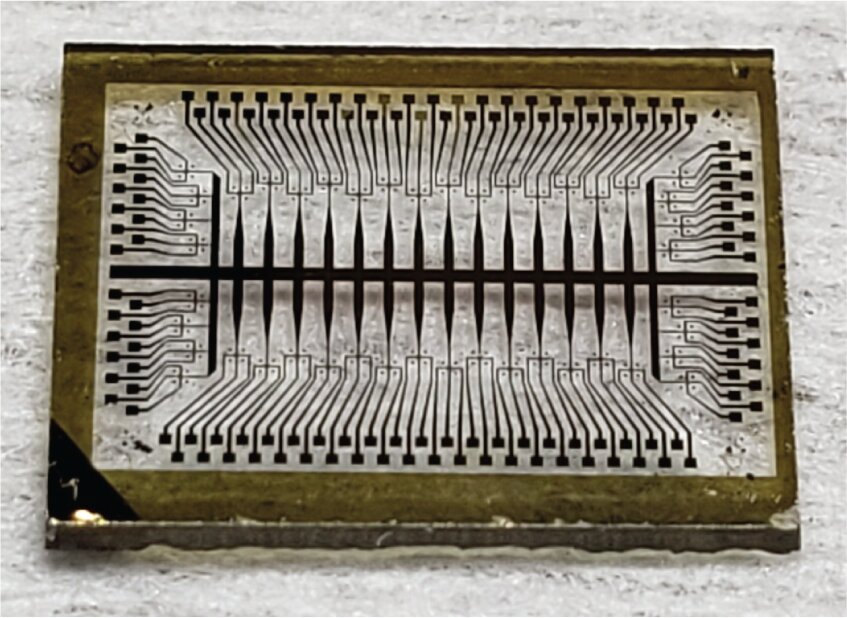

Para implementar o dispositivo, os pesquisadores primeiro fabricaram uma série desses dispositivos chamados de ativação (ou neurônio), junto com uma matriz de dispositivos sinápticos. Em seguida, eles integraram os dois arrays em uma placa de circuito impresso personalizada e os conectaram para criar uma versão de hardware de uma rede neural.

Os pesquisadores usaram a rede para processar uma imagem – neste caso, uma foto da Biblioteca Geisel na UC San Diego. A rede executava um tipo de processamento de imagem denominado detecção de bordas, que identifica os contornos ou bordas dos objetos em uma imagem. Este experimento demonstrou que o sistema de hardware integrado pode realizar operações de convolução que são essenciais para muitos tipos de redes neurais profundas.

Os pesquisadores afirmam que a tecnologia pode ser ampliada para realizar tarefas mais complexas, como reconhecimento facial e de objetos em carros autônomos. Com o interesse e a colaboração da indústria, isso pode acontecer, observou Kuzum.

“No momento, esta é uma prova de conceito”, disse Kuzum. “É um sistema minúsculo no qual empilhamos apenas uma camada de sinapse com uma camada de ativação. Empilhando mais dessas camadas, você poderia fazer um sistema mais complexo para diferentes aplicações.”

Publicado em 20/03/2021 23h28

Artigo original:

Estudo original: