Avanços recentes no aprendizado de máquina permitiram o desenvolvimento de técnicas para detectar e reconhecer emoções humanas. Algumas dessas técnicas funcionam analisando os sinais de eletroencefalografia (EEG), que são essencialmente registros da atividade elétrica do cérebro coletada no couro cabeludo de uma pessoa.

A maioria dos métodos de classificação de emoções baseados em EEG, introduzidos na última década, emprega técnicas tradicionais de aprendizado de máquina (ML), como modelos de máquina de vetores de suporte (SVM), pois esses modelos exigem menos amostras de treinamento e ainda falta um EEG em larga escala. conjuntos de dados. Recentemente, no entanto, os pesquisadores compilaram e lançaram vários novos conjuntos de dados contendo registros cerebrais de EEG.

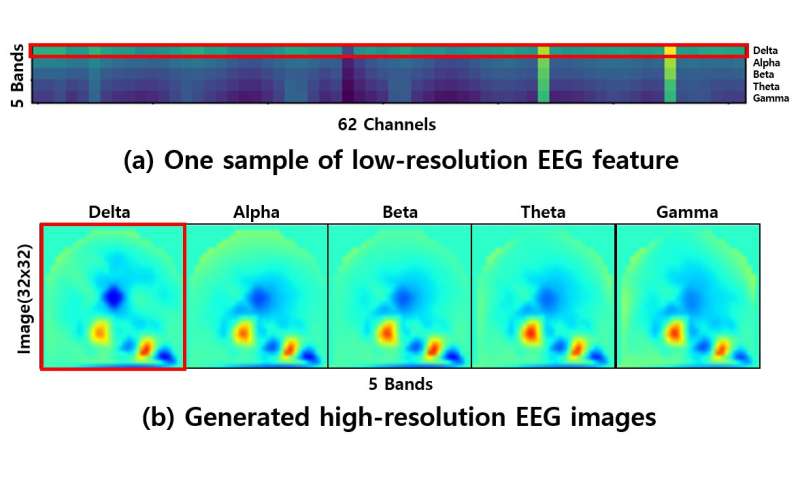

O lançamento desses conjuntos de dados abre novas e empolgantes possibilidades para o reconhecimento de emoções baseado em EEG, pois elas podem ser usadas para treinar modelos de aprendizado profundo que alcançam melhor desempenho do que as técnicas tradicionais de ML. Infelizmente, no entanto, a baixa resolução dos sinais de EEG contidos nesses conjuntos de dados pode dificultar o treinamento de modelos de aprendizado profundo.

“Problemas de baixa resolução continuam sendo um problema para a classificação emocional baseada no EEG”, disse Sunhee Hwang, um dos pesquisadores que realizou o estudo, ao TechXplore. “Temos uma ideia para resolver esse problema, que envolve a geração de imagens de EEG de alta resolução”.

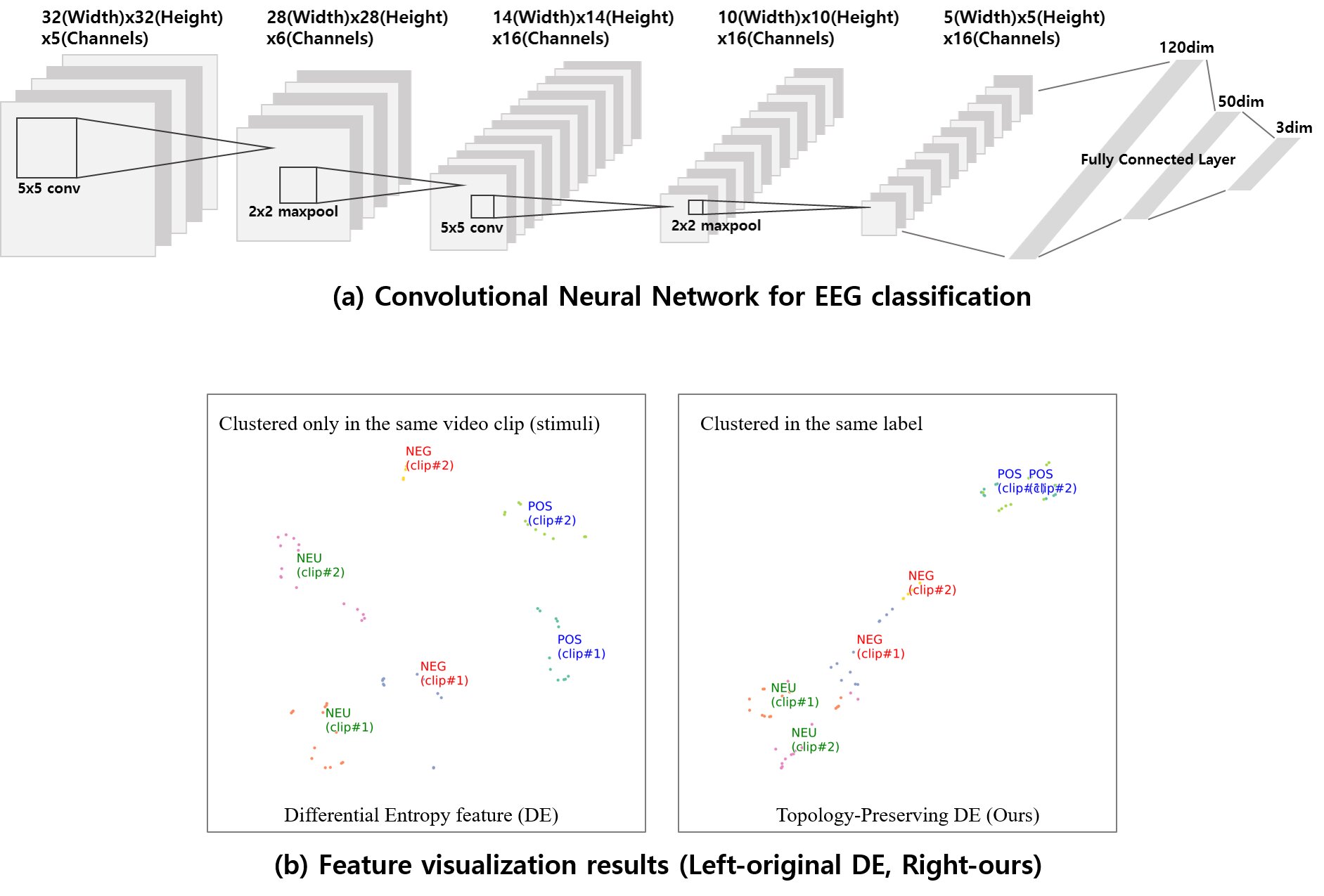

Para aprimorar a resolução dos dados de EEG disponíveis, Hwang e seus colegas geraram os chamados “recursos de entropia diferencial de preservação de topologia” usando as coordenadas do eletrodo no momento em que os dados foram coletados. Posteriormente, eles desenvolveram uma rede neural convolucional (CNN) e a treinaram nos dados atualizados, ensinando-o a estimar três classes gerais de emoções (ou seja, positivas, neutras e negativas).

“Métodos anteriores tendem a ignorar as informações de topologia dos recursos de EEG, mas nosso método aprimora a representação de EEG aprendendo as imagens de EEG de alta resolução geradas”, disse Hwang. “Nosso método agrupa novamente os recursos do EEG por meio da CNN proposta, o que permite que o efeito do agrupamento alcance uma melhor representação”.

Os pesquisadores treinaram e avaliaram sua abordagem no conjunto de dados SEED, que contém sinais EEG de 62 canais. Eles descobriram que seu método podia classificar emoções com uma precisão média notável de 90,41%, superando outras técnicas de aprendizado de máquina para reconhecimento de emoções baseado em EEG.

“Se os sinais de EEG são gravados a partir de diferentes clipes emocionais, os recursos originais de DE não podem ser agrupados”, acrescentou Hwang. “Também aplicamos nosso método na tarefa de estimar a vigilância de um motorista para mostrar sua disponibilidade imediata”.

No futuro, o método proposto por Hwang e seus colegas poderá informar o desenvolvimento de novas ferramentas de reconhecimento de emoções baseadas em EEG, pois apresenta uma solução viável para superar os problemas associados à baixa resolução dos dados de EEG. A mesma abordagem também pode ser aplicada a outros modelos de aprendizado profundo para a análise de dados de EEG, mesmo aqueles projetados para algo que não seja a classificação das emoções humanas.

“Para tarefas de visão computacional, conjuntos de dados em larga escala permitiram o enorme sucesso de modelos de aprendizado profundo para classificação de imagens, alguns dos quais ultrapassaram o desempenho humano”, disse Hwang. “Além disso, o pré-processamento de dados complexos não é mais necessário. Em nosso trabalho futuro, esperamos gerar conjuntos de dados de EEG em larga escala usando uma rede adversária gerada (GAN)”.

Publicado em 24/12/2019

Artigo original:

Achou importante? Compartilhe!

Assine nossa newsletter e fique informado sobre Astrofísica, Biofísica, Geofísica e outras áreas. Preencha seu e-mail no espaço abaixo e clique em “OK”: