O medo da inteligência artificial (IA) é tão palpável que existe toda uma escola de filosofia tecnológica dedicada a descobrir como a IA pode desencadear o fim da humanidade. Não quero alimentar a paranóia de ninguém, mas aqui está uma lista de momentos em que a IA causou – ou quase causou – um desastre.

O péssimo conselho do chatbot da Air Canada

A Air Canada foi levada ao tribunal depois que uma das ferramentas assistidas por IA da empresa deu conselhos incorretos para garantir uma tarifa de passagem de luto.

Enfrentando uma ação legal, os representantes da Air Canada argumentaram que não foram culpados por algo que seu chatbot fez.

Além do enorme dano à reputação possível em cenários como esse, se não se pode acreditar nos chatbots, eles prejudicam o já desafiador mundo da compra de passagens aéreas.

A Air Canada foi forçada a devolver quase metade da tarifa devido ao erro.

Gafe de implementação do site de Nova York

Bem-vindo à cidade de Nova York, a metrópole que nunca dorme e a cidade com a maior gafe de implementação de IA na memória recente.

Descobriu-se que um chatbot chamado MyCity incentivava proprietários de empresas realizando atividades ilegais.

De acordo com o chatbot, você poderia roubar uma parte das gorjetas dos seus funcionários, ficar sem dinheiro e pagar-lhes menos do que o salário mínimo.

Tweets inapropriados do bot da Microsoft

Em 2016, a Microsoft lançou um bot do Twitter chamado Tay, que deveria interagir como um adolescente americano, aprendendo à medida que avançava.

Em vez disso, aprendeu a compartilhar tweets radicalmente inapropriados.

A Microsoft culpou outros usuários por esse desenvolvimento, que bombardearam Tay com conteúdo repreensível.

A conta e o bot foram removidos menos de um dia após o lançamento.

É um dos exemplos básicos de um projeto de IA indo para o lado.

Conteúdo gerado por IA da Sports Illustrated

Em 2023, a Sports Illustrated foi acusada de implantar IA para escrever artigos.

Isso levou ao rompimento da parceria com uma empresa de conteúdo e à investigação de como esse conteúdo passou sendo publicado.

Demissão em massa devido a IA discriminatória

Em 2021, os líderes do parlamento holandês, incluindo o primeiro-ministro, demitiram-se depois de uma investigação ter descoberto que, nos oito anos anteriores, mais de 20.000 famílias foram defraudadas devido a um algoritmo discriminatório.

A IA em questão pretendia identificar aqueles que fraudaram a rede de segurança social do governo, calculando o nível de risco dos requerentes e destacando quaisquer casos suspeitos.

O que realmente aconteceu foi que milhares de pessoas foram forçadas a pagar com fundos que não tinham por serviços de cuidados infantis de que necessitavam desesperadamente.

Conselho prejudicial do chatbot médico

A National Eating Disorder Association causou grande rebuliço quando anunciou que substituiria sua equipe humana por um programa de IA.

Pouco depois, os usuários da linha direta da organização descobriram que o chatbot, apelidado de Tessa, dava conselhos prejudiciais para quem sofria de transtorno alimentar.

Houve acusações de que a mudança para o uso de um chatbot também foi uma tentativa de acabar com os sindicatos.

É mais uma prova de que a IA médica voltada para o público pode causar consequências desastrosas se não estiver pronta ou for capaz de ajudar as massas.

Ferramenta discriminatória de recrutamento de IA da Amazon

Em 2015, foi encontrada uma ferramenta de recrutamento de IA da Amazon que discriminava as mulheres.

Treinada com base em dados dos últimos 10 anos de candidatos, a grande maioria dos quais eram homens, a ferramenta de aprendizagem automática tinha uma visão negativa dos currículos que utilizavam a palavra “mulheres” e era menos propensa a recomendar formandos de faculdades femininas.

A equipe por trás da ferramenta foi dividida em 2017, embora o preconceito baseado na identidade na contratação, incluindo o racismo e a capacidade, não tenha desaparecido.

Resultados de pesquisa racista do Imagens do Google

O Google teve que remover a capacidade de pesquisar gorilas em seu software de IA depois que os resultados recuperaram imagens de pessoas negras. Outras empresas, incluindo a Apple, também enfrentaram ações judiciais por alegações semelhantes.

A IA ameaçadora do Bing

Normalmente, quando falamos sobre a ameaça da IA, referimo-nos a isso de uma forma existencial: ameaças ao nosso trabalho, à segurança dos dados ou à compreensão de como o mundo funciona. O que normalmente não esperamos é uma ameaça à nossa segurança.

Quando lançado pela primeira vez, o Bing AI da Microsoft rapidamente ameaçou um ex-estagiário da Tesla e um professor de filosofia, professou seu amor eterno a um proeminente colunista de tecnologia e alegou que havia espionado funcionários da Microsoft.

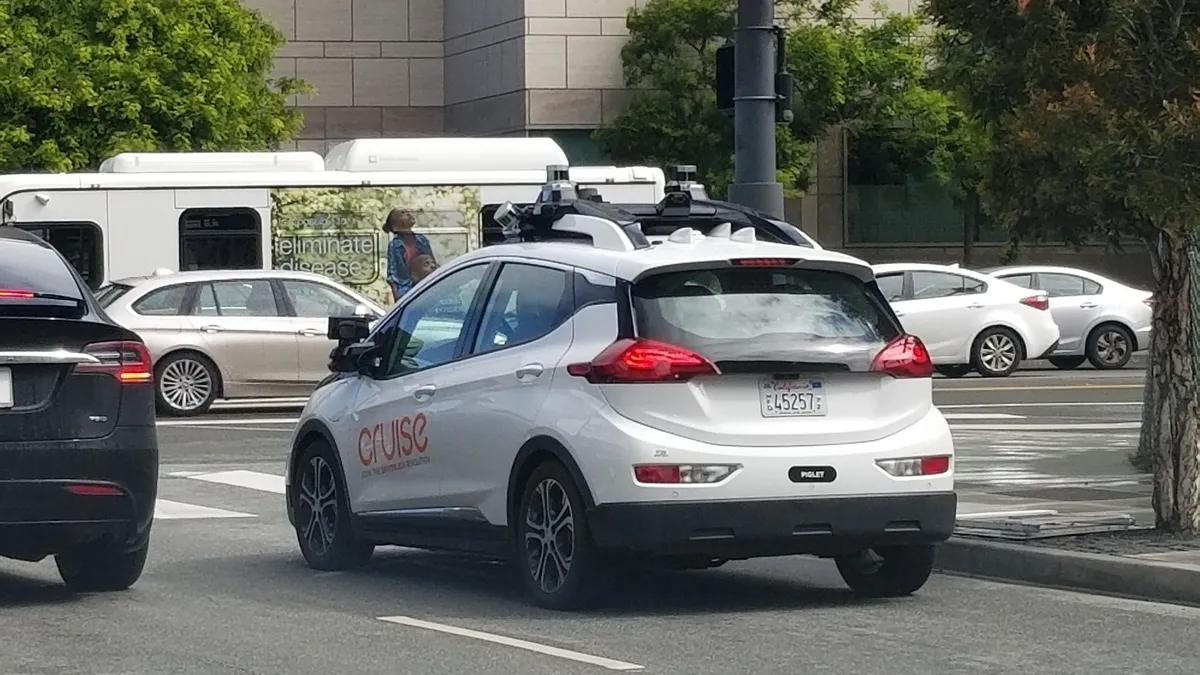

Desastre de carro sem motorista

Embora a Tesla tenda a dominar as manchetes quando se trata do que há de bom e de ruim na IA sem motorista, outras empresas causaram sua própria cota de carnificina. Um deles é o Cruise da GM. Um acidente em outubro de 2023 feriu gravemente um pedestre após ser colocado no caminho de um modelo Cruise. A partir daí, o carro deslocou-se para o acostamento da estrada, arrastando consigo o pedestre ferido.

Esse não foi o fim. Em fevereiro de 2024, o estado da Califórnia acusou Cruise de enganar os investigadores sobre a causa e os resultados do ferimento.

Publicado em 18/06/2024 19h07

Artigo original: