Quando os humanos olham para uma cena, eles veem objetos e as relações entre eles. Em cima da sua mesa, pode haver um laptop à esquerda de um telefone, que está na frente de um monitor de computador.

Muitos modelos de aprendizagem profunda lutam para ver o mundo dessa maneira porque não entendem as relações emaranhadas entre os objetos individuais. Sem o conhecimento dessas relações, um robô projetado para ajudar alguém em uma cozinha teria dificuldade em seguir um comando como “pegue a espátula que está à esquerda do fogão e coloque-a em cima da tábua de cortar”.

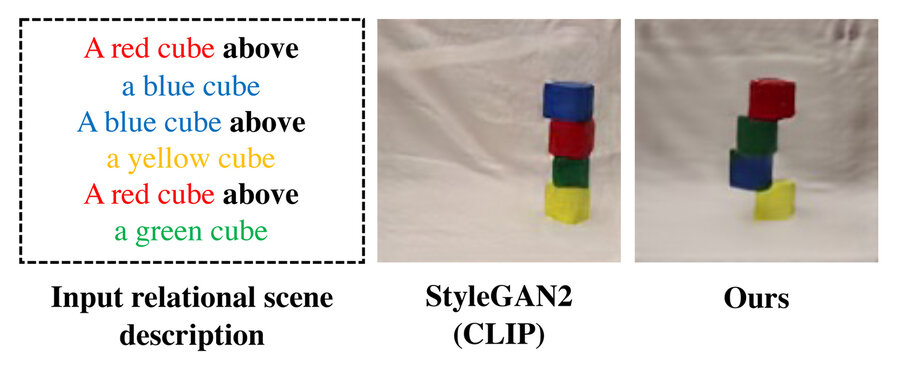

Em um esforço para resolver esse problema, os pesquisadores do MIT desenvolveram um modelo que entende as relações subjacentes entre os objetos em uma cena. Seu modelo representa relacionamentos individuais um de cada vez e, em seguida, combina essas representações para descrever a cena geral. Isso permite que o modelo gere imagens mais precisas a partir de descrições de texto, mesmo quando a cena inclui vários objetos que estão dispostos em relações diferentes uns com os outros.

Esse trabalho pode ser aplicado em situações em que robôs industriais devem realizar tarefas complexas de manipulação em várias etapas, como empilhar itens em um depósito ou montar aparelhos. Ele também move o campo um passo mais perto de capacitar máquinas que podem aprender e interagir com seus ambientes mais como os humanos fazem.

“Quando eu olho para uma mesa, não posso dizer que há um objeto no local XYZ. Nossas mentes não funcionam assim. Em nossas mentes, quando entendemos uma cena, realmente a entendemos com base nas relações entre os objetos. Acreditamos que, ao construir um sistema que possa entender as relações entre os objetos, poderíamos usar esse sistema para manipular e alterar de forma mais eficaz nossos ambientes “, diz Yilun Du, um Ph.D. estudante do Laboratório de Ciência da Computação e Inteligência Artificial (CSAIL) e co-autora principal do artigo.

Du escreveu o artigo com os co-autores principais Shuang Li, um CSAIL Ph.D. estudante, e Nan Liu, uma estudante de graduação na Universidade de Illinois em Urbana-Champaign; bem como Joshua B. Tenenbaum, Professor de Desenvolvimento de Carreira Paul E. Newton de Ciência Cognitiva e Computação no Departamento de Cérebro e Ciências Cognitivas e membro do CSAIL; e o autor sênior Antonio Torralba, professor de Engenharia Elétrica e Ciência da Computação da Delta Electronics e membro do CSAIL. A pesquisa será apresentada na Conferência sobre Sistemas de Processamento de Informação Neural em dezembro.

Um relacionamento de cada vez

A estrutura desenvolvida pelos pesquisadores pode gerar uma imagem de uma cena baseada em uma descrição textual de objetos e suas relações, como “Uma mesa de madeira à esquerda de um banquinho azul. Um sofá vermelho à direita de um banquinho azul”.

Seu sistema iria quebrar essas frases em duas partes menores que descrevem cada relacionamento individual (“uma mesa de madeira à esquerda de um banquinho azul” e “um sofá vermelho à direita de um banquinho azul”) e, em seguida, modelar cada parte separadamente . Essas peças são então combinadas por meio de um processo de otimização que gera uma imagem da cena.

Os pesquisadores usaram uma técnica de aprendizado de máquina chamada modelos baseados em energia para representar os relacionamentos de objetos individuais em uma descrição de cena. Essa técnica permite que eles usem um modelo baseado em energia para codificar cada descrição relacional e, em seguida, componha-os juntos de uma forma que infere todos os objetos e relacionamentos.

Ao quebrar as frases em pedaços mais curtos para cada relacionamento, o sistema pode recombiná-las de várias maneiras, de modo que é mais capaz de se adaptar a descrições de cena que não tenha visto antes, Li explica.

“Outros sistemas tomariam todas as relações holisticamente e gerariam a imagem one-shot a partir da descrição. No entanto, tais abordagens falham quando temos descrições fora de distribuição, como descrições com mais relações, uma vez que esses modelos não podem realmente se adaptar uma foto para gerar imagens contendo mais relacionamentos. No entanto, como estamos compondo esses modelos menores e separados juntos, podemos modelar um número maior de relacionamentos e nos adaptar a novas combinações “, diz Du.

O sistema também funciona ao contrário – dada uma imagem, ele pode encontrar descrições de texto que correspondem às relações entre os objetos na cena. Além disso, seu modelo pode ser usado para editar uma imagem reorganizando os objetos na cena para que correspondam a uma nova descrição.

Compreendendo cenas complexas

Os pesquisadores compararam seu modelo a outros métodos de aprendizagem profunda que receberam descrições de texto e tiveram a tarefa de gerar imagens que exibiam os objetos correspondentes e seus relacionamentos. Em cada instância, seu modelo superou as linhas de base.

Eles também pediram aos humanos que avaliassem se as imagens geradas correspondiam à descrição da cena original. Nos exemplos mais complexos, em que as descrições continham três relacionamentos, 91 por cento dos participantes concluíram que o novo modelo teve um desempenho melhor.

“Uma coisa interessante que descobrimos é que, para nosso modelo, podemos aumentar nossa frase de ter uma descrição de relação para ter duas, ou três, ou mesmo quatro descrições, e nossa abordagem continua a ser capaz de gerar imagens que são corretamente descritas por aqueles descrições, enquanto outros métodos falham “, diz Du.

Os pesquisadores também mostraram as imagens do modelo de cenas que ele não tinha visto antes, bem como várias descrições de texto diferentes de cada imagem, e foi capaz de identificar com sucesso a descrição que melhor correspondia às relações de objeto na imagem.

E quando os pesquisadores deram ao sistema duas descrições de cenas relacionais que descreviam a mesma imagem, mas de maneiras diferentes, o modelo foi capaz de entender que as descrições eram equivalentes.

Os pesquisadores ficaram impressionados com a robustez de seu modelo, especialmente ao trabalhar com descrições que não haviam encontrado antes.

“Isso é muito promissor porque está mais próximo de como os humanos funcionam. Os humanos podem ver apenas vários exemplos, mas podemos extrair informações úteis apenas desses poucos exemplos e combiná-los para criar combinações infinitas. E nosso modelo tem uma propriedade que permite para aprender com menos dados, mas generalizar para cenas ou gerações de imagens mais complexas “, diz Li.

Embora esses resultados iniciais sejam encorajadores, os pesquisadores gostariam de ver como seu modelo se comporta em imagens do mundo real que são mais complexas, com fundos barulhentos e objetos que estão bloqueando uns aos outros.

Eles também estão interessados em eventualmente incorporar seu modelo em sistemas robóticos, permitindo que um robô inferir relações de objetos a partir de vídeos e, em seguida, aplicar esse conhecimento para manipular objetos no mundo.

“O desenvolvimento de representações visuais que podem lidar com a natureza composicional do mundo ao nosso redor é um dos principais problemas em aberto na visão computacional. Este artigo faz um progresso significativo nesse problema ao propor um modelo baseado em energia que modela explicitamente as relações múltiplas entre os objetos retratada na imagem. Os resultados são realmente impressionantes “, disse Josef Sivic, um renomado pesquisador do Instituto Tcheco de Informática, Robótica e Cibernética da Universidade Técnica Tcheca, que não esteve envolvido nesta pesquisa.

Publicado em 30/11/2021 21h38

Artigo original:

Estudo original: