Pesquisadores da Universidade de Tecnologia de Tianjin, na China, desenvolveram recentemente uma nova estrutura baseada em redes cerebrais para reconhecer as emoções de pessoas surdas. Este framework, apresentado em um artigo publicado no IEEE Sensors Journal, é baseado especificamente em uma técnica computacional conhecida como stacking ensemble learning, que combina as previsões feitas por vários algoritmos de aprendizado de máquina diferentes.

“Na comunicação diária com alunos surdos, descobrimos que eles reconhecem as emoções de outras pessoas com base principalmente na observação visual”, disse Yu Song, um dos pesquisadores que realizou o estudo, ao Tech Xplore. “Em comparação com pessoas normais, também existem certas diferenças na percepção das emoções pelos surdos, o que pode causar alguns problemas, como desvios psicológicos na vida diária.”

A maioria dos estudos anteriores com o objetivo de desenvolver modelos de reconhecimento de emoções foi realizada em indivíduos sem deficiências sensoriais. Song e seus colegas se propuseram a preencher essa lacuna na literatura, desenvolvendo uma estrutura que possa classificar especificamente as emoções de indivíduos surdos.

Em primeiro lugar, os pesquisadores examinaram as diferenças na atividade cerebral e conectividade funcional entre indivíduos sem deficiência auditiva e indivíduos surdos quando em três diferentes estados emocionais (positivo, neutro e negativo). Para fazer isso, eles recrutaram 15 alunos surdos na Universidade de Tecnologia de Tianjin e coletaram gravações cerebrais semelhantes às do conjunto de dados SEED, um conjunto de dados renomado contendo vários sinais de EEG de indivíduos sem deficiência auditiva.

“Normalmente, as características do EEG são extraídas do domínio do tempo, domínio da frequência e domínio da frequência do tempo para o reconhecimento de emoções”, explicou Song. “Isso ocorre porque a teoria da neurociência sugere que os processos cognitivos são refletidos pela propagação de informações no cérebro e interações entre diferentes regiões cerebrais. Portanto, decidimos desenvolver um novo modelo de aprendizagem de conjunto de empilhamento de rede cerebral para reconhecimento de emoção que combina as informações coletadas por diferentes algoritmos. ”

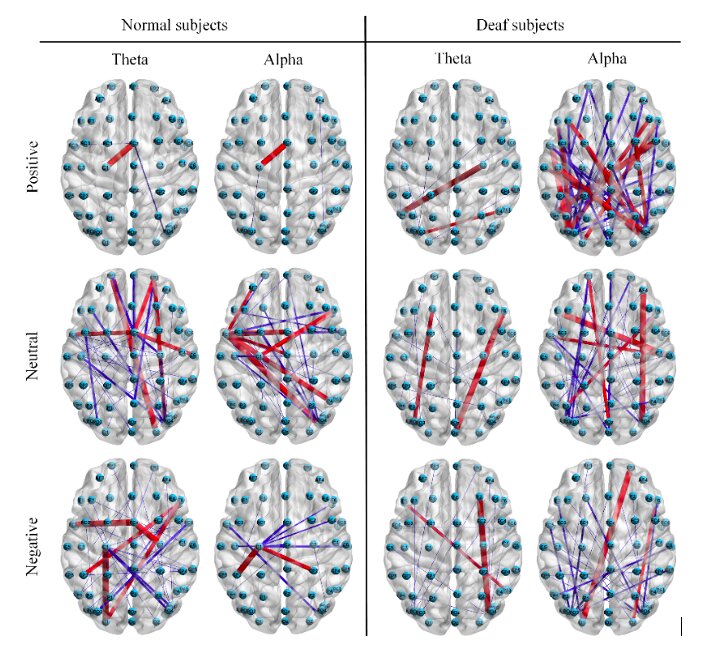

Em seu experimento inicial, Song e seus colegas descobriram que a seleção do valor limite desempenhou um papel importante na construção da rede cerebral. Para reduzir as conexões falsas e reter as válidas, eles propuseram o uso de limiares que eram duplos para binários na matriz de conexão do valor de bloqueio de fase (PLV). O PLV é uma medida da sincronia de fase entre duas séries temporais diferentes, amplamente usada para examinar a conectividade do cérebro por meio da análise de dados de imagem, como varreduras de MEG e EEG.

“Em seguida, extraímos os recursos globais e locais da rede cerebral e usamos a estrutura de aprendizagem de conjunto de empilhamento que desenvolvemos para classificar os recursos extraídos”, disse Song. “Nossos resultados experimentais mostram que o modelo proposto pode aprender recursos de EEG discriminativos e de domínio robusto para melhorar a precisão do reconhecimento de emoção. Diferentemente do aprendizado profundo, nosso modelo também é adequado para dados de amostra pequena e pode efetivamente reduzir o risco de overfitting.”

Em seus experimentos, Song e seus colegas descobriram que seu modelo podia reconhecer as emoções de indivíduos surdos com uma precisão significativamente maior do que reconhecia as emoções de pessoas sem deficiência auditiva. Uma possível explicação para isso é que os surdos têm uma compreensão mais simples das emoções devido à falta de um canal associado à aquisição de emoções.

Notavelmente, o modelo dos pesquisadores superou significativamente outros modelos de última geração para reconhecimento de emoções. Além disso, a equipe descobriu que as diferenças na atividade cerebral e conectividade funcional entre sujeitos surdos e sem deficiência auditiva eram mais óbvias em estados de carga emocional do que em condições neutras.

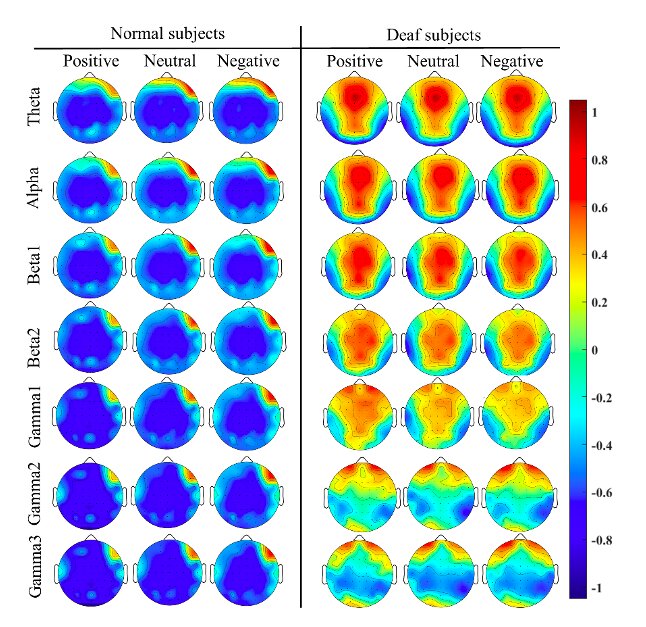

“Para indivíduos normais, descobrimos que os lobos pré-frontal e temporal esquerdo são provavelmente a área de informação emocional mais abundante, investigando a atividade cerebral”, disse Song. “Para sujeitos surdos, os lobos frontal, temporal e occipital são provavelmente a área de informação de reconhecimento de emoção mais abundante.”

O estudo forneceu informações valiosas sobre as diferenças entre a atividade cerebral de surdos e ouvintes em diferentes estados emocionais. Por exemplo, Song e seus colegas observaram que, em comparação com sujeitos auditivos, sujeitos surdos exibem maior ativação nos lobos occipital e parietal e menor ativação no lobo temporal. Essas diferenças podem estar relacionadas ao mecanismo de compensação no cérebro de participantes surdos enquanto assistiam aos clipes de filmes emocionais mostrados a eles durante o experimento.

“Descobrimos que, para indivíduos normais, as relações intercanais locais entre os lobos frontais podem fornecer informações úteis para o reconhecimento de emoções, e as relações intercanais globais entre os lobos frontal, parietal e occipital também podem fornecer informações úteis”, disse Song. “Para sujeitos surdos, por outro lado, as relações intercanais globais entre os lobos frontal, temporal e occipital são de grande importância para o reconhecimento de emoções, bem como as relações intercanais entre os hemisférios direito e esquerdo do cérebro também podem fornecer informação útil.”

O estudo pode ter várias implicações importantes. Em primeiro lugar, o trabalho pode melhorar a compreensão atual de como os estados emocionais se manifestam no cérebro de indivíduos surdos e como isso difere do processamento emocional em pessoas sem deficiência auditiva.

Além disso, o modelo de reconhecimento de emoção que desenvolveram pode ser usado para identificar as emoções de pessoas surdas, tanto no cotidiano quanto no ambiente clínico. Além disso, o trabalho dos pesquisadores pode informar o desenvolvimento de estratégias para reduzir as diferenças na cognição emocional entre surdos e ouvintes.

O modelo pode atualmente atingir uma precisão de aproximadamente 60% em todos os assuntos quando aplicado aos 15 participantes surdos que eles recrutaram. No futuro, Song e seus colegas esperam melhorar o desempenho de seu modelo e sua capacidade de generalizar bem entre diferentes indivíduos.

“Recentemente, também começamos a recrutar mais sujeitos surdos para participarem do experimento de reconhecimento de emoções EEG, e as categorias de emoções incluem diversão, encorajamento, calma, tristeza, raiva e medo”, acrescentou Song. “Continuaremos a expandir nosso conjunto de dados e fornecê-lo gratuitamente aos pesquisadores mundiais em trabalhos posteriores para que eles possam estudar o mecanismo nervoso do cérebro de sujeitos surdos em diferentes estados emocionais.”

Publicado em 01/10/2021 08h33

Artigo original:

Estudo original: