Pesquisadores da Universidade de Michigan desenvolveram recentemente um modelo bidirecional que pode prever o quanto humanos e agentes robóticos podem ser confiáveis em situações que envolvem a colaboração humano-robô. Este modelo, apresentado em um artigo publicado na IEEE Robotics and Automation Letters, pode ajudar a alocar tarefas para diferentes agentes de forma mais confiável e eficiente.

“Tem havido muitas pesquisas para entender por que os humanos devem ou não confiar em robôs, mas infelizmente, sabemos muito menos sobre por que robôs devem ou não confiar em humanos”, Herbert Azevedo-Sa, um dos pesquisadores que realizaram o estudo, disse TechXplore. “Em um trabalho verdadeiramente colaborativo, no entanto, a confiança precisa ir em ambas as direções. Com isso em mente, queríamos construir robôs que pudessem interagir e construir confiança em humanos ou em outros agentes, da mesma forma que um par de colegas de trabalho que colaboram . ”

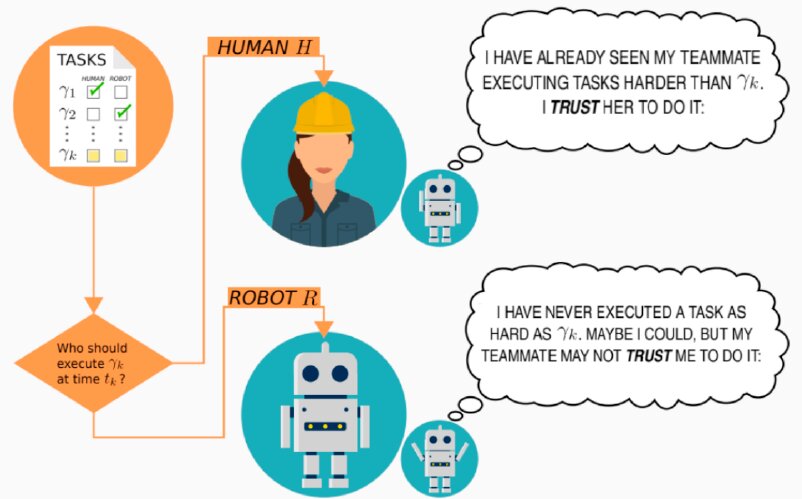

Quando os humanos colaboram em uma determinada tarefa, eles normalmente observam aqueles com quem estão colaborando e tentam entender melhor quais tarefas podem e não podem completar com eficiência. Ao se conhecerem e aprenderem no que os outros são melhores ou piores, eles estabelecem algum tipo de harmonia.

“É aqui que a confiança entra em jogo: você constrói a confiança do seu colega para fazer algumas tarefas, mas não outras”, explicou Azevedo-Sa. “Isso também acontece com seu colega de trabalho, que constrói confiança em você para algumas tarefas, mas não para outras.”

Como parte de seu estudo, Azevedo-Sa e seus colegas tentaram replicar o processo pelo qual os humanos aprendem quais tarefas outras pessoas com as quais estão colaborando podem ou não ser confiáveis no uso de um modelo computacional. O modelo que eles criaram pode representar a confiança de um humano e de um robô, portanto, pode fazer previsões sobre o quanto os humanos confiam nele e sobre o quanto ele pode confiar em um humano para concluir uma determinada tarefa.

“Uma das grandes diferenças entre confiar em um humano e em um robô é que os humanos podem ter a capacidade de realizar bem uma tarefa, mas não têm integridade e benevolência para realizá-la”, explicou Azevedo-Sa. “Por exemplo, um colega de trabalho humano pode ser capaz de realizar uma tarefa bem, mas não aparecer para o trabalho quando deveria (ou seja, sem integridade) ou simplesmente não se importar em fazer um bom trabalho (ou seja, sem benevolência) . Um robô deve, portanto, incorporar isso em sua estimativa de confiança no ser humano, enquanto um humano só precisa considerar se o robô tem a capacidade de executar bem a tarefa. ”

O modelo desenvolvido pelos pesquisadores fornece uma representação geral das capacidades de um agente, que pode incluir informações sobre suas habilidades, integridade e outros fatores semelhantes, ao mesmo tempo que considera os requisitos da tarefa que o agente deve executar. Essa representação das capacidades de um agente é então comparada aos requisitos da tarefa que deve ser concluída.

Se um agente é considerado mais do que capaz de executar uma determinada tarefa, o modelo considera o agente como altamente digno de confiança. Por outro lado, se uma tarefa é particularmente desafiadora e um agente não parece ser capaz o suficiente ou não tem as qualidades necessárias para completá-la, a confiança do modelo no agente torna-se baixa.

“Essas representações de capacidade do agente também podem mudar com o tempo, dependendo de quão bem o agente executa as tarefas atribuídas a ele”, disse Azevedo-Sa. “Essas representações de agentes e tarefas em termos de capacidades e requisitos são vantajosas, porque capturam explicitamente o quão difícil é uma tarefa e permitem que essa dificuldade seja combinada com as capacidades de diferentes agentes.”

Em contraste com outros modelos desenvolvidos anteriormente para prever o quanto os agentes podem ser confiáveis, o modelo apresentado por esta equipe de pesquisadores é aplicável tanto a humanos quanto a robôs. Além disso, quando avaliaram seu modelo, Azevedo-Sa e seus colegas descobriram que ele previa confiança com muito mais confiabilidade do que outros modelos existentes.

“Abordagens anteriores tentavam prever a transferência de confiança avaliando como as tarefas eram semelhantes, com base em sua descrição verbal”, disse Azevedo-Sa. “Essas abordagens representaram um grande primeiro passo para os modelos de confiança, mas tiveram alguns problemas. Por exemplo: as tarefas ‘pegar um lápis’ e ‘pegar uma baleia’ têm descrições muito semelhantes, mas na verdade são muito diferentes. ”

Essencialmente, se um robô pegasse ou agarrasse com eficiência um lápis, as abordagens desenvolvidas anteriormente para prever a confiança assumiriam automaticamente que o mesmo robô poderia ser confiável para pegar um item muito maior (por exemplo, uma baleia). Por outro lado, ao representar as tarefas em termos de seus requisitos, o modelo idealizado por Azevedo-Sa e seus colegas poderia evitar esse erro, diferenciando os diferentes objetos que um robô deve pegar.

No futuro, o novo modelo bidirecional poderá ser usado para aprimorar a colaboração humano-robô em uma variedade de configurações. Por exemplo, pode ajudar a alocar tarefas de forma mais confiável entre equipes compostas por agentes humanos e robóticos.

“Gostaríamos de eventualmente aplicar nosso modelo para resolver o problema de alocação de tarefas que mencionamos antes”, disse Azevedo-Sa. “Em outras palavras, se um robô e um humano estão trabalhando juntos executando um conjunto de tarefas, a quem cada tarefa deve ser atribuída? No futuro, esses agentes provavelmente poderão negociar quais tarefas deverão ser atribuídas a cada um deles, mas suas opiniões irão dependem fundamentalmente da confiança mútua. Queremos, portanto, investigar como podemos construir nosso modelo de confiança para alocar tarefas entre humanos e robôs. ”

Publicado em 30/06/2021 12h33

Artigo original:

Estudo original: