Um universo evolui ao longo de bilhões e bilhões de anos, mas os pesquisadores desenvolveram uma maneira de criar um universo simulado complexo em menos de um dia. A técnica, publicada nos Proceedings of the National Academy of Sciences desta semana, reúne Machine Learning, computação de alto desempenho e astrofísica e ajudará a inaugurar uma nova era de simulações cosmológicas de alta resolução.

As simulações cosmológicas são uma parte essencial para desvendar os muitos mistérios do universo, incluindo os da matéria escura e da energia escura. Mas até agora, os pesquisadores enfrentaram o dilema comum de não ser capaz de ter tudo ¬ – as simulações poderiam se concentrar em uma pequena área em alta resolução, ou poderiam abranger um grande volume do universo em baixa resolução.

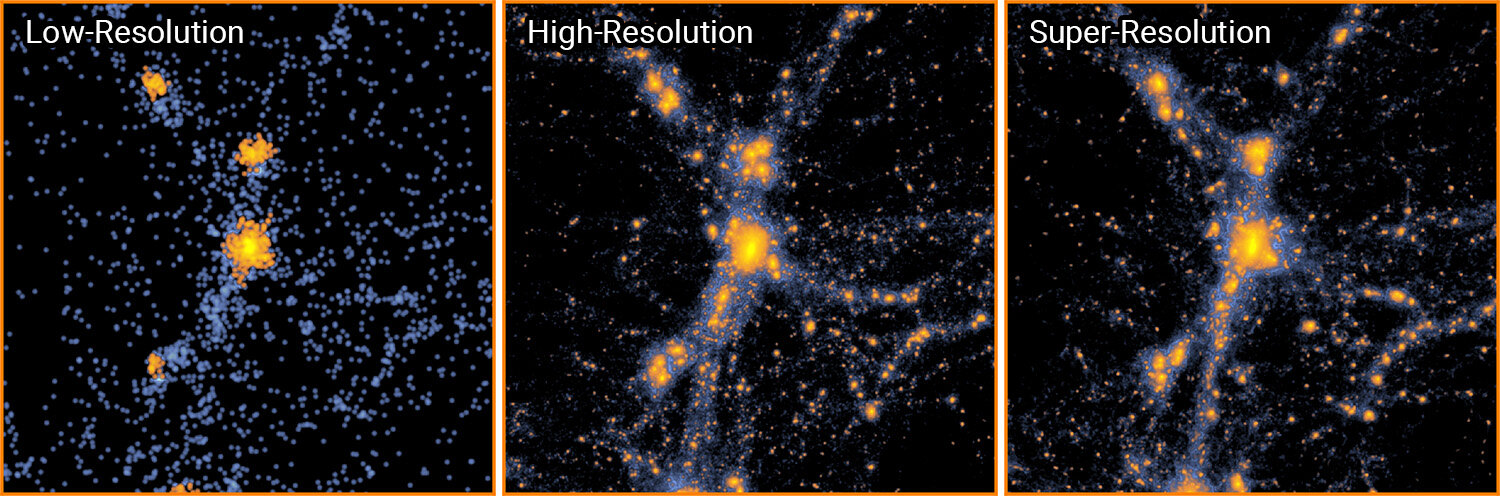

Professores de Física da Carnegie Mellon University Tiziana Di Matteo e Rupert Croft, Flatiron Institute Research Fellow Yin Li, Carnegie Mellon Ph.D. o candidato Yueying Ni, professor de física e astronomia da University of California Riverside, Simeon Bird, e Yu Feng, da University of California Berkeley, superou esse problema ensinando um algoritmo de Machine Learning baseado em redes neurais para atualizar uma simulação de baixa resolução para super resolução.

“As simulações cosmológicas precisam cobrir um grande volume para estudos cosmológicos, ao mesmo tempo em que exigem alta resolução para resolver a física da formação de galáxias em pequena escala, o que incorreria em desafios computacionais assustadores. Nossa técnica pode ser usada como uma ferramenta poderosa e promissora para combinar os dois requisitos simultaneamente modelando a física da formação de galáxias em pequena escala em grandes volumes cosmológicos “, disse Ni, que realizou o treinamento do modelo, construiu o pipeline de teste e validação, analisou os dados e fez a visualização a partir dos dados.

O código treinado pode pegar modelos em escala real e de baixa resolução e gerar simulações de super-resolução que contêm até 512 vezes mais partículas. Para uma região no universo de aproximadamente 500 milhões de anos-luz contendo 134 milhões de partículas, os métodos existentes exigiriam 560 horas para produzir uma simulação de alta resolução usando um único núcleo de processamento. Com a nova abordagem, os pesquisadores precisam de apenas 36 minutos.

Os resultados foram ainda mais dramáticos quando mais partículas foram adicionadas à simulação. Para um universo 1.000 vezes maior com 134 bilhões de partículas, o novo método dos pesquisadores levou 16 horas em uma única unidade de processamento gráfico. Usando os métodos atuais, uma simulação desse tamanho e resolução levaria meses para um supercomputador dedicado ser concluída.

Reduzir o tempo que leva para executar simulações cosmológicas “tem o potencial de fornecer grandes avanços em cosmologia numérica e astrofísica”, disse Di Matteo. “Simulações cosmológicas seguem a história e o destino do universo, até a formação de todas as galáxias e seus buracos negros.”

Os cientistas usam simulações cosmológicas para prever como o universo seria em vários cenários, como se a energia escura que separa o universo variasse ao longo do tempo. As observações do telescópio então confirmam se as previsões das simulações correspondem à realidade.

“Com nossas simulações anteriores, mostramos que poderíamos simular o universo para descobrir física nova e interessante, mas apenas em escalas pequenas ou de baixa resolução”, disse Croft. “Ao incorporar o Machine Learning, a tecnologia é capaz de acompanhar nossas ideias.”

Di Matteo, Croft e Ni fazem parte do Instituto de Planejamento da Fundação Nacional da Ciência (NSF) da Carnegie Mellon para Inteligência Artificial em Física, que apoiou este trabalho, e membros do McWilliams Center for Cosmology da Carnegie Mellon.

“O universo é o maior conjunto de dados que existe – a inteligência artificial é a chave para entender o universo e revelar a nova física”, disse Scott Dodelson, professor e chefe do departamento de física da Carnegie Mellon University e diretor do NSF Planning Institute. “Esta pesquisa ilustra como o NSF Planning Institute for Artificial Intelligence avançará a física por meio da inteligência artificial, Machine Learning, estatística e ciência de dados.”

“Está claro que a IA está tendo um grande efeito em muitas áreas da ciência, incluindo física e astronomia”, disse James Shank, diretor do programa da Divisão de Física da NSF. “Nosso programa do AI planning Institute está trabalhando para impulsionar a IA para acelerar a descoberta. Este novo resultado é um bom exemplo de como a IA está transformando a cosmologia.”

Para criar seu novo método, Ni e Li aproveitaram esses campos para criar um código que usa redes neurais para prever como a gravidade move a matéria escura ao longo do tempo. As redes obtêm dados de treinamento, executam cálculos e comparam os resultados com o resultado esperado. Com mais treinamento, as redes se adaptam e se tornam mais precisas.

A abordagem específica usada pelos pesquisadores, chamada rede adversarial geradora, coloca duas redes neurais uma contra a outra. Uma rede pega simulações de baixa resolução do universo e as usa para gerar modelos de alta resolução. A outra rede tenta diferenciar essas simulações daquelas feitas por métodos convencionais. Com o tempo, ambas as redes neurais ficam cada vez melhores até que, no final das contas, o gerador de simulação vence e cria simulações rápidas que se parecem com as convencionais lentas.

“Não conseguimos fazer funcionar por dois anos”, disse Li, “e de repente começou a funcionar. Obtivemos resultados lindos que corresponderam ao que esperávamos. Até fizemos alguns testes cegos, e a maioria de nós não sabia dizer qual era ‘real’ e qual era ‘falso’. ”

Apesar de serem treinadas apenas em pequenas áreas do espaço, as redes neurais replicaram com precisão as estruturas de grande escala que só aparecem em enormes simulações.

As simulações não capturaram tudo, no entanto. Por se concentrarem na matéria escura e na gravidade, fenômenos de escala menor – como a formação de estrelas, supernovas e os efeitos dos buracos negros – foram deixados de fora. Os pesquisadores planejam estender seus métodos para incluir as forças responsáveis por tais fenômenos e executar suas redes neurais ‘em tempo real’ ao lado de simulações convencionais para melhorar a precisão.

Publicado em 08/05/2021 03h17

Artigo original: