A capacidade de raciocinar abstratamente sobre os eventos à medida que eles se desenrolam é uma característica definidora da inteligência humana. Sabemos instintivamente que chorar e escrever são meios de comunicação e que um panda caindo de uma árvore e um avião pousando são variações da descida.

Organizar o mundo em categorias abstratas não é algo fácil para os computadores, mas, nos últimos anos, os pesquisadores se aproximaram, treinando modelos de aprendizado de máquina em palavras e imagens infundidas com informações estruturais sobre o mundo e como objetos, animais e ações se relacionam. Em um novo estudo na Conferência Europeia sobre Visão Computacional deste mês, os pesquisadores revelaram um modelo híbrido de linguagem-visão que pode comparar e contrastar um conjunto de eventos dinâmicos capturados em vídeo para revelar os conceitos de alto nível que os conectam.

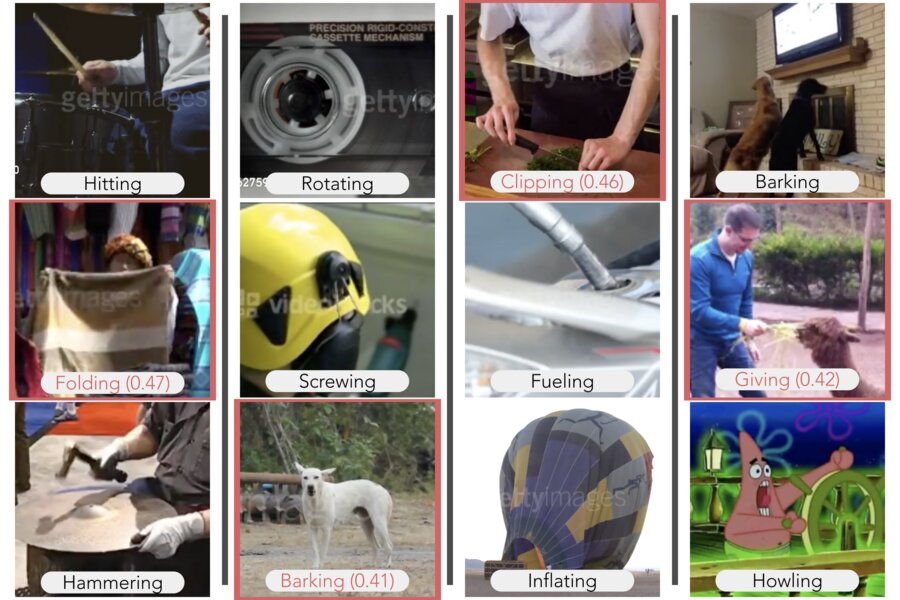

O modelo deles se saiu tão bem ou melhor do que os humanos em dois tipos de tarefas de raciocínio visual – escolher o vídeo que conceitualmente melhor completa o conjunto e escolher o vídeo que não se encaixa. Exibindo vídeos de um cachorro latindo e um homem uivando ao lado de seu cachorro, por exemplo, a modelo completou o conjunto escolhendo o bebê chorando de um conjunto de cinco vídeos. Os pesquisadores replicaram seus resultados em dois conjuntos de dados para o treinamento de sistemas de IA em reconhecimento de ação: Multi-Moments in Time do MIT e Kinetics da DeepMind.

“Nós mostramos que você pode construir abstração em um sistema de IA para realizar tarefas comuns de raciocínio visual próximas a um nível humano”, disse a autora sênior do estudo, Aude Oliva, pesquisadora sênior do MIT, codiretora do MIT Quest for Intelligence, e diretor do MIT do MIT-IBM Watson AI Lab. “Um modelo que pode reconhecer eventos abstratos dará previsões mais precisas e lógicas e será mais útil para a tomada de decisões.”

À medida que as redes neurais profundas se tornam especialistas em reconhecer objetos e ações em fotos e vídeos, os pesquisadores se voltam para o próximo marco: abstração e modelos de treinamento para raciocinar sobre o que vêem. Em uma abordagem, os pesquisadores fundiram o poder de correspondência de padrões de redes profundas com a lógica de programas simbólicos para ensinar um modelo a interpretar relacionamentos de objetos complexos em uma cena. Aqui, em outra abordagem, os pesquisadores capitalizam as relações embutidas nos significados das palavras para dar ao seu modelo poder de raciocínio visual.

“As representações de linguagem nos permitem integrar informações contextuais aprendidas de bancos de dados de texto em nossos modelos visuais”, diz o co-autor do estudo Mathew Monfort, pesquisador do Laboratório de Ciência da Computação e Inteligência Artificial do MIT (CSAIL). “Palavras como ‘correr’, ‘levantar’ e ‘boxear’ compartilham algumas características comuns que as tornam mais relacionadas ao conceito de ‘fazer exercícios’, por exemplo, do que ‘dirigir’.”

Usando WordNet, um banco de dados de significados de palavras, os pesquisadores mapearam a relação de cada rótulo de classe de ação em Momentos e Cinética com os outros rótulos em ambos os conjuntos de dados. Palavras como “esculpir”, “entalhar” e “cortar”, por exemplo, estavam conectadas a conceitos de nível superior como “criar”, “fazer arte” e “cozinhar”. Agora, quando o modelo reconhece uma atividade como esculpir, ele pode selecionar atividades conceitualmente semelhantes no conjunto de dados.

Este gráfico relacional de classes abstratas é usado para treinar o modelo para realizar duas tarefas básicas. Dado um conjunto de vídeos, o modelo cria uma representação numérica para cada vídeo que se alinha com as representações de palavras das ações mostradas no vídeo. Um módulo de abstração então combina as representações geradas para cada vídeo no conjunto para criar uma nova representação de conjunto que é usada para identificar a abstração compartilhada por todos os vídeos no conjunto.

Para ver como o modelo se sairia em comparação com os humanos, os pesquisadores pediram que os seres humanos realizassem o mesmo conjunto de tarefas de raciocínio visual online. Para sua surpresa, o modelo teve um desempenho tão bom quanto o dos humanos em muitos cenários, às vezes com resultados inesperados. Em uma variação da tarefa de conclusão de set, após assistir a um vídeo de alguém embrulhando um presente e cobrindo um item com fita adesiva, a modelo sugeriu um vídeo de alguém na praia enterrando outra pessoa na areia.

“É efetivamente uma ‘cobertura’, mas muito diferente das características visuais dos outros clipes”, diz Camilo Fosco, um estudante de Ph.D. no MIT que é co-autor do estudo com o estudante de Ph.D. Alex Andonian. “Conceitualmente se encaixa, mas eu tive que pensar sobre isso.”

As limitações do modelo incluem a tendência de superestimar alguns recursos. Em um caso, sugeriu completar um conjunto de vídeos esportivos com um vídeo de um bebê e uma bola, aparentemente associando bolas a exercícios e competição.

Um modelo de aprendizado profundo que pode ser treinado para “pensar” de forma mais abstrata pode ser capaz de aprender com menos dados, dizem os pesquisadores. A abstração também abre caminho para um raciocínio de nível mais alto e mais semelhante ao humano.

“Uma marca registrada da cognição humana é nossa capacidade de descrever algo em relação a outra – para comparar e contrastar”, diz Oliva. “É uma maneira rica e eficiente de aprender que pode eventualmente levar a modelos de aprendizado de máquina que podem entender analogias e estão muito mais perto de se comunicar de forma inteligente conosco.”

Publicado em 02/09/2020 05h13

Artigo original:

Estudo original:

Achou importante? Compartilhe!

Assine nossa newsletter e fique informado sobre Astrofísica, Biofísica, Geofísica e outras áreas. Preencha seu e-mail no espaço abaixo e clique em “OK”: